APPARATUS AND METHOD FOR ESTIMATING HAND POSITION UTILIZING HEAD MOUNTED COLOR DEPTH CAMERA, AND BARE HAND INTERACTION SYSTEM USING SAME

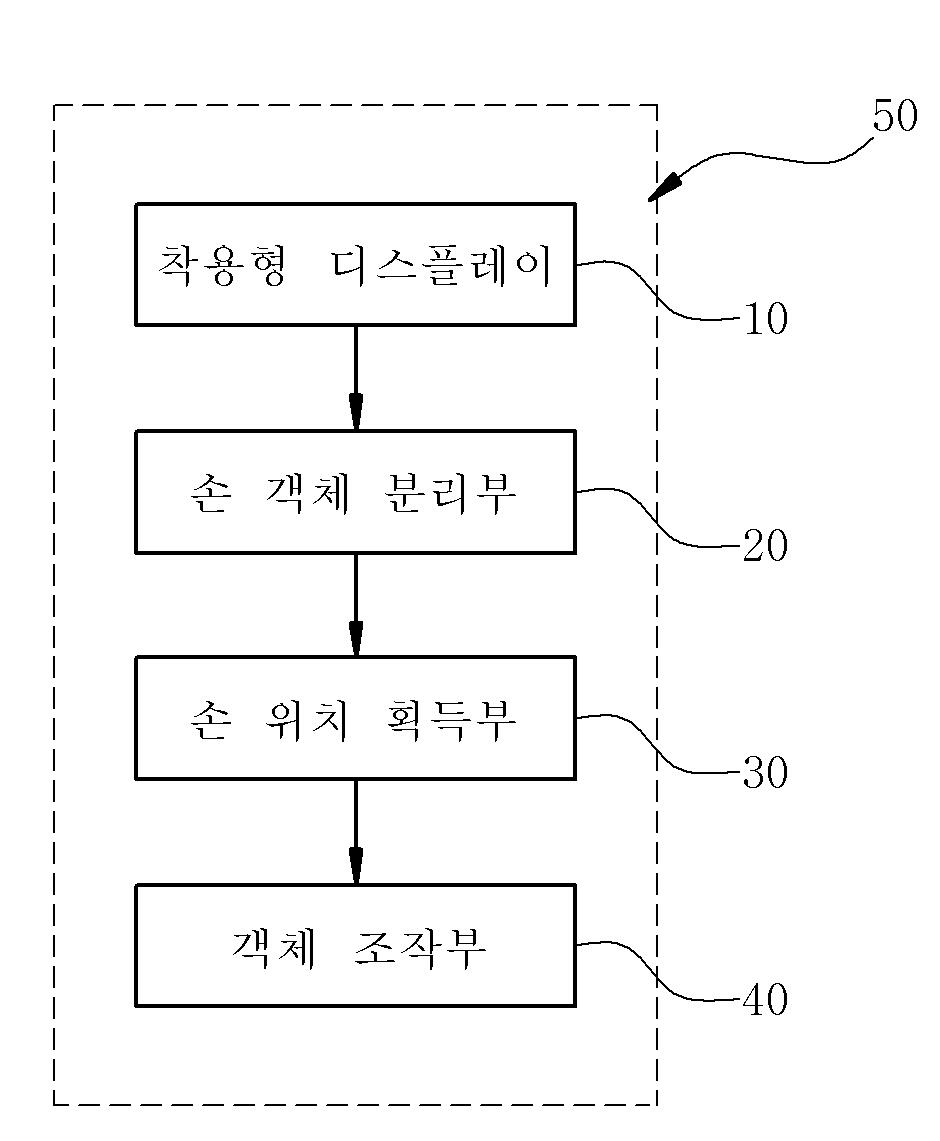

본 발명은 사용자가 착용형 증강 현실 (wearable AR) 환경에서 맨 손 (Bare Hand)으로 가상 3D 객체를 조작할 수 기술에 관한 것으로, 특히 공간(환경)에 설치된 별도의 손, 카메라 추적 장치 없이도, RGB-D 카메라의 거리 입력 데이터를 이용하여, 공간에서 안경형 디스플레이에 장착된 근/원거리 카메라 쌍의 3차원 위치와 사용자의 손의 3차원 위치를 알아낼 수 있는 기술(Localization).이며 착용형 AR 환경에서 손을 사용자 인터페이스로 사용하는 다양한 3D 상호 작용 시나리오에 적용할 수 있는 기술이다. 또한 본 발명은 이러한 손 위치 추정을 기반으로 증강현실 환경에서 맨 손 상호작용 시 사용자의 시각적 거리 인지를 향상시킬 수 있는 기술에 관한 것이다. 최근 소형화, 경량화된, 착용형 머리 장착 디스플레이(HWD: Head-Worn Display)와 RGB-깊이(RGB-Depth) 카메라가 개발됨에 따라 착용형 증강 현실(Wearable AR) 의 발전이 가속화되고 있다. 이동형 (Mobile) 사용자는 현장에서 관심 객체, 환경, 작업 등에 대한 유용한 디지털 정보를 즉각적으로 안경을 통해 볼 수 있으며 조작할 수 있다. 착용형 AR의 상호 작용을 위한 다양한 사용자 인터페이스가 있지만, 손에 근거한 상호 작용은 가장 직관적이며 자연스러운, 그리고 쉽게 사용할 수 있는 사용자 입력 방법으로 간주된다. 일반적으로 가상 현실연구에서 가상 객체와 상호 작용을 하기 위해서는, 사용자의 머리와 손 위치를 인식하기 위한 별도의 추적(Tracking) 인프라를 사용하였다. 환경(천장, 테이블, 또는 벽 등)에 설치된 추적기(Tracker)를 통해 머리와 손의 정확한 위치를 알 수 있다. 그러나 이러한 환경에 설치된 추적 장치가 없는 착용형 AR 환경은 새로운 기술적 과제를 제기한다. 우선 공간으로부터 사용자의 머리와 손의 위치를 아는 것이 어렵기 때문에, 3차원 상호 작용이 매우 어렵다. 일부 연구는 3차원 공간 상에서 손의 위치를 알아내지 않고, 2차원 영상 입력을 기반으로 한 상호 작용을 지원한다. 또는 손 자세를 감지하기 위해 손이나 손가락에 트래킹 마커 또는 센서를 부착, 또는 손목에 있는 작은 카메라를 장착하여 손의 자세를 인식하기도 한다. 또 다른 시스템은 3차원 공간에서 손의 상대적인 위치를 알아내지만, 공간에 고정된 카메라를 기준으로 작동이 되기 때문에, 모바일 사용자를 지원할 수 없다. 이러한 문제를 해결하기 위해, RGB-D 카메라의 깊이 맵 이미지에서 손 객체를 인식하고 위치를 추정하여 카메라 좌표계를 기준으로 맨손의 3차원 위치를 추적한다. 그리고 3차원 공간 상에 손의 위치는 SLAM(동시 지역화 및 매핑) 기반의 카메라 위치 추적 방법을 이용한다. 이때 SLAM 기반 공간의 임의 스케일 단위를 깊이 맵 정보를 이용하여 mm 스케일 단위로 일치시킨다. 이러한 방법을 통해 SLAM 기반 3차원 공간에 증강된 가상객체를 손으로 조작할 수 있다. 사용자의 실제 손의 위치와 회전에 가상의 손의 위치 및 회전을 매핑하기 위해 다양한 6 자유도(DOF) 추적 장치들이 사용되었다. 예를 들면, Go-Go 손 기술은 사용자의 몸체로부터 손의 위치를 알기 위해 2 개의 전자 추적 시스템을 사용했다. 착용형 AR에서, 손을 이용한 상호 작용은 손의 위치 추정(Localization) 기술의 성능에 의해 방법이 결정된다. WearTrack 시스템은 착용형 컴퓨터, 휴대용 VR를 위한 머리와 손 트래커를 제안하였지만, 전자기 추적기가 손에 장착되어야 있어야 했다. 가상 터치 스크린 시스템, AR 메모 및 SixthSense는 2 차원 이미지 좌표계를 기준으로 손인식을 가능하게 하였다. 하지만, 3 차원 손의 위치 추정을 하지 않았기 때문에, 착용형 AR에서의 3D 상호 작용을 지원할 수 없었다. 종래 Tinmith과 FingARtips은 3D 공간에서 사용자의 손을 인식하기 위해 장갑에 부착하는 마커(Marker)를 사용하였다 하지만, 장갑을 착용하는 것은 불편하며, 마커의 크기와 방향에 따라 손 인식의 성능이 달라진다. HandyAR은 맨손의 손가락을 추적하여 가상 객체의 3 차원 조작을 가능하게 한다. 하지만, 미리 정의된 손가락 모양만 인식하며, 초기에 손과 가상 세계 사이의 스케일 매핑을 설정해야 한다. 최근 3 차원 핸드 상호 작용은 깊이 데이터에서 거리 정보를 이용하여, 손 영역을 분리/인식하는 연구들이 있다. 또한 깊이 카메라들을 이용하여 실시간으로 손의 골격를 추적하기도 한다(예 Gestigon leap motion SoftKinetic 3Gear 시스템). 그러나 이러한 방법은 일반적으로 환경에 고정된 카메라를 기반으로 한, 데스크톱 기반 컴퓨팅 환경에 적합하다. AR의 경우, 기존 연구들에서, 기준 마커와 고정형 카메라를 이용하여 주위 배경을 학습한 후, 손 인식을 가능하게 한다. 그러나, 카메라가 이동하는 경우에는 환경 정보가 변경하게 되고, 배경 학습 기반의 손 분리 및 인식 방법이 실패할 수 있다. 한편, 가상 현실연구에서 손을 이용한 상호 작용은 사전에 주어진 가상 공간 모델을 이용하여 그림자와 가림 효과 (Occlusion effect)을 생성하였는데, 이는 조작하고자하는 대상 객체의 위치를 인지하는데 도움이 된다. 착용형 AR은 일반적으로 (HWD: Head-Worn Display)를 기반으로 한 1인칭 시점을 사용하고 있는데, 공간에 증강된 가상객체가 디스플레이되는 영상을 렌더링하기 때문에 사용자의 손 등을 가리는 경우가 자주 발생한다. 이러한 경우 사용자는 가상 객체를 효과적으로 조작하는데 어려움을 겪는다. VR(Virtual Reality)에서는 모델링된 환경에서 월드 좌표계 기준 머리, 손 및 가상 물체의 정확한 위치를 알고 있다. 따라서 깊이 인식을 위한 가림 모델과 그림자를 렌더링하는 것이 쉽다. 그러나 AR에서는 가상 객체가 손 앞에 또는 뒤에 있는지 여부를 아는 것이 어렵다. 착용형 AR의 1인칭 시점에서는 이 문제가 더욱 중요하고 복잡하다. 공간에 증강된 가상 물체가 수시로 사용자의 손을 가리기 때문에, 조작할 때 필요한 깊이 인식을 할 수 없다. 가상 객체를 가리기 위해서, 손을 3D 점군 (Point cloud)을 복셀 (Voxel) 렌더링을 통해 투명하게 만들 수 있다. 하지만, 가상 객체가 손에 의해 가려지기 때문에, 가상 객체의 존재 및 위치를 확인하는 것이 어려울 수 있다. 본 발명은 상기와 같은 종래의 문제점을 해결하기 위하여 제안된 것으로, 본 발명은 사용자가 착용형 증강 현실 (wearable AR) 환경에서 맨 손 (Bare Hand)으로 가상 3D 객체를 조작할 수 시스템 및 방법을 제공하는데 기술적 목적이 있다. 또한, 본 발명은 손 뒤의 대상 객체를 보여주기 위해 사용자의 손을 반 투명한 복셀로 렌더링하는 방법, 환경의 자연스러운 가림을 위한 투명한 복셀 렌더링, 그리고 그림자 효과를 위한 회색의 복셀 렌더링을 제안하고자 한다. 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치는 사용자는 사용자의 머리에 착용되어, 전방을 영상 촬영하는 컬러-깊이 카메라를 장착하고, 공간 정합된 증강현실 영상을 사용자에 제공하는 착용형 디스플레이, 컬러-깊이 카메라에서 획득한 깊이맵 영상으로부터, 손 객체를 분리하는 손 객체 분리부 및 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하여 손 위치를 획득하는 손 위치 획득부를 포함하는 것을 특징으로 한다. 또한 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 방법은(a) 컬러-깊이 카메라를 통해 사용자 전방을 영상 촬영하는 단계, (b) 손 객체 분리부를 이용하여 컬러-깊이 카메라에서 획득한 깊이맵 영상으로부터, 손 객체를 분리하는 단계, (c) 손 위치 획득부를 이용하여 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하여 손 위치를 획득하는 단계, (d) 착용형 디스플레이를 통해 정합된 영상을 제공하는 단계 및 (e) 객체 조작부를 이용하여, 사용자의 손의 동작에 따라 가상 3D 객체를 선택하고 조작하는 단계를 포함하는 것을 특징으로 한다. 또한, 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템은 컬러-깊이 카메라를 통해 촬영된 영상에서 카메라 좌표계를 기준으로 손의 3D 특징을 추출하고 AR 공간의 로컬 참조 좌표계를 기준으로 가상 손 모델을 사용자의 손 위치에 정합하여 제공하는 손 위치 추정 장치부 및 상기 손 위치 추정 장치부와 연결되어, 사용자의 시각적 거리를 인지하여 상호작용 피드백을 제공하는 거리 인지 피드백부를 포함하는 것을 특징으로 한다. 본 발명은 공간(환경)에 설치된 별도의 손, 카메라 추적 장치 없이도, RGB-D 카메라의 거리 입력 데이터를 이용함으로써, 공간에서 착용형 디스플레이에 장착된 근/원거리 카메라 쌍의 3차원 위치와 사용자의 손의 3차원 위치를 알아낼 수 있는 효과가 있다. 본 발명은 손 뒤의 대상 객체를 보여주기 위해 사용자의 손을 반 투명한 복셀로 렌더링하고, 환경의 자연스러운 가림을 위한 투명한 복셀 렌더링, 그림자 효과를 위한 회색의 복셀 렌더링을 통해 증강현실 환경에서 손을 이용한 상호작용 시 거리 인지 향상을 위한 시각적 거리를 인지하는데 효과가 있다. 도 1은 본 발명에 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치의 전체 구성을 나타내는 구성도. 도 2는 본 발명에 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치의 기술적 특징을 설명하는 개념도. 도 3은 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 방법의 전체 흐름을 나타내는 흐름도. 도 4는 본 발명에 있어서, 깊이 카메라의 구성을 나타내는 일실시예 도면. 도 5는 본 발명에 있어서, 머리 장착 근거리 RGB-D 카메라에서의 손 객체 인식 개념을 나타내는 도면. 도 6은 본 발명에 있어서, 이미지, 카메라 및 월드 좌표계 간의 관계를 나타내는 도면. 도 7은 본 발명에 있어서, 가상 카메라의 거리 개념을 나타내는 도면. 도 8은 본 발명에 있어서, 가상손을 이용한 3D 조작 모습을 나타내는 도면. 도 9는 본 발명을 응용한 다양한 실시예를 나타내는 도면. 도 10은 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템에 있어서, 사용자의 시각적 거리 인지 향상 방법이 적용된 화면 예시도. 도 11은 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템에 있어서, 거리 인지 피드백부의 상세 구성을 나타내는 도면. 도 12는 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템에 있어서, 깊이 인지 향상을 위한 시각적 피드백 관련 화면 예시도. 도 13은 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템에 있어서, 반 투명 회색 그림자 및 가이드 라인 관련 화면 예시도. 도 14는 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템에 있어서, 환경 가림 효과 관련 반투명한 손 렌더링에 관한 예시도. 이하 본 발명에 따른 바람직한 실시 예를 첨부한 도면을 참조하여 상세히 설명한다. 하기 설명에서는 구체적인 구성 소자 등과 같은 특정 사항들이 나타나고 있는데 이는 본 발명의 보다 전반적인 이해를 돕기 위해서 제공된 것일 뿐 이러한 특정 사항들이 본 발명의 범위 내에서 소정의 변형이나 혹은 변경이 이루어질 수 있음은 이 기술 분야에서 통상의 지식을 가진 자에게는 자명하다 할 것이다. 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치는 도 1에 도시된 바와 같이, 사용자의 머리에 착용되어, 전방을 영상 촬영하는 컬러-깊이 카메라를 장착하고, 공간 정합된 증강현실 영상을 사용자에 제공하는 착용형 디스플레이(10), 컬러-깊이 카메라에서 획득한 깊이맵 영상으로부터, 손 객체를 분리하는 손 객체 분리부(20), 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하여 손 위치를 획득하는 손 위치 획득부(30) 및 사용자의 손의 동작에 따라 가상 3D 객체를 선택하고 조작하는 객체 조작부(40)를 포함한다. 도 2는 사용자 착용형 카메라 이외에 별도의 추가적인 센서 장치 없이, 손 위치를 추적하여, 착용형 AR 환경에서 맨손으로 가상 3D 개체를 선택하고 조작할 수 있도록 하는 본 발명에 따른 손 위치 추정 장치의 주요 특징을 나타내는 도면으로, (a) 사용자는 근/원거리의 컬러-깊이 카메라 (RGB-Depth camera) 가 장착된 착용형 디스플레이(10)를 착용하고 있다. (b) 카메라 좌표계를 기준으로 손의 3D 특징을 추출한다. (C) 가상 손이 AR 공간의 기준 좌표계를 기준으로 렌더링한다. (d) 손으로 가상 3D 객체를 선택하고 조작할 수 있다. 도 3은 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치를 이용한 손 위치 추정 방법의 흐름을 나타내는 것으로 착용형 디스플레이(10)에 장착된 RGB-D 카메라(11, 12)의 쌍이 색상 및 깊이 맵 이미지를 획득한 후, 카메라 좌표계를 기준으로 손 객체를 분리한다. 그리고 AR 공간의 로컬 참조 좌표계 (Local reference coordinates) 를 기준으로 가상 손 모델을 사용자의 손 위치에 정합한다. 주먹을 쥐거나 펴는 제스처를 인식하여 가상 객체를 선택하고 해제하는 등의 이벤트를 발생시킨다. 도 4에 도시된 일실시예와 같이, 상기 착용형 디스플레이(10)에는 근거리 깊이 카메라(11) 및 장거리 깊이 카메라(12)가 결합되어 있으며, 상기 근거리 깊이 카메라(11)는 손을 감지하고, 장거리 카메라는 환경으로부터 카메라 쌍의 위치를 알아내고, 물리적인 세계와 가상세계 사이의 스케일 정보를 보정하는데 사용된다. 다양한 거리로 깊이 측정이 가능한 카메라가 개발된다면, 본 발명에서 사용하는 2개의 카메라 시스템은 1개로 단일화될 수 있다. 상기 근거리 깊이 카메라(11)는 손 트래킹에 사용되며, 상기 원거리 깊이카메라(12)는 환경으로부터 카메라 쌍의 위치를 획득하고, 현실과-가상 공간내의 스케일 파라미터를 보정하기 위해서 사용된다. 상기 손 객체 분리부(20)는 도 5에 도시된 바와 같이, 상기 컬러-깊이 카메라에서 획득한 깊이맵 영상으로부터 손 객체를 분리하며, 분리된 손 객체 영상의 노이즈를 제거하고, 최대 크기의 윤곽 (Contour)을 획득하는 윤곽 획득부 및 거리 변환 (Distance transform)를 수행하여, 가장 높은 강도를 가지는 화소의 픽셀 좌표를 손바닥의 중심 위치로 정의하는 거리 변환부를 포함한다. 즉, 상기 손 객체 분리부(20)는 도 6에 도시된 개념도와 같이, 상기 컬러-깊이 카메라(11, 12)에서 획득한 깊이맵 영상으로부터, 손 객체를 분리할 때, 영상의 노이즈 (Jitter)를 감소시키기 위한 이미지 침식 등을 작업을 수행한 후, 최대 크기의 윤곽 (Contour)을 얻는다. 그리고 거리 변환 (Distance transform)를 수행 하여, 가장 높은 강도를 가지는 화소의 픽셀 좌표를 손바닥의 중심 위치로 정의한다. 그 다음, 상기 손 위치 획득부(30)으로 사용자 손의 위치를 획득하며, 본 발명에 따른 손 위치 획득부(30)는 이미지 좌표계로부터 카메라 좌표계로 손의 픽셀 좌표를 역투영(Back projection)하여 카메라 좌표계를 기준으로 손의 3차원 위치를 계산하고, SLAM 기반의 카메라 추적 방법으로 손 위치를 추적하는 손 좌표 획득부 및 로컬 좌표계에 대한, SLAM(Scanning Laser Acoustic Microscope) 기반의 가상 카메라의 거리와 깊이 카메라의 거리의 비율을 계산하여 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하는 손 정합부를 포함한다. 이를 보다 자세히 설명하면 도 6에 도시된 바와 같이, 카메라 좌표계를 기준으로 손의 3차원 위치 Pc=[Xc, Yc, Zc]를 계산한다. 이를 위해서 이미지 좌표계로부터 카메라 좌표계로 손의 픽셀 좌표를 역투영 (Back projection) 한다 ( 수학식 1 및 수학식 2 ). 여기서, K는 카메라 보정 (Camera calibration)를 통해 사전에 알고 있다. 그리고 이미지 좌표계에서의 손의 픽셀 좌표는 앞서 수행했던 손 객체 인식으로부터 알 수 있다. 깊이 정보인 Zc는 깊이 맵 이미지의 픽셀 값으로 알 수 있다. 수학식 1 수학식 2 그 다음 수학식 3 과 같이, Pc을 SLAM 기반의 카메라 추적 방법으로 얻은 카메라 자세 행렬을 역으로 곱하여, 환경의 로컬 참조 좌표계로 손의 좌표를 이동시킬 수 있다. 그러나 그 좌표의 스케일은 SLAM의 스케일에 의존하고 있어, 깊이 카메라를 기준으로 획득한 손 좌표의 스케일(mm 단위)과는 다르다. 수학식 3 따라서 두 공간의 스케일을 일치시키기 위해서 스케일 비율 λ를 계산한다. 도 7에 도시된 바와 같이 로컬 좌표계 (TOrigin)에 대한, SLAM 기반의 가상 카메라의 거리와 깊이 카메라의 거리 (mm 단위)의 비율을 다음 수학식 4로 계산한다. 수학식 4 그 결과 환경(현실 공간)에서 손 위치 Pw를 계산할 수 있고, 도 8 및 도 9에 도시된 바와 같이, 환경에 정합된 가상 객체들을 손으로 조작할 수 있다. 그리고 사용자의 손은 수학식 5와 같이 다양한 가상 손 맵핑 방법에 의해 다양한 위치 Pv로 확장될 수 있다. 수학식 5 이러한 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치를 이용한 맨 손 상호작용 시스템을 설명하면 다음과 같다. 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템은 컬러-깊이 카메라를 통해 촬영된 영상에서 카메라 좌표계를 기준으로 손의 3D 특징을 추출하고 AR 공간의 로컬 참조 좌표계를 기준으로 가상 손 모델을 사용자의 손 위치에 정합하여 제공하는 손 위치 추정 장치부 및 상기 손 위치 추정 장치부와 연결되어, 사용자의 시각적 거리를 인지하여 상호작용 피드백을 제공하는 거리 인지 피드백부를 포함한다. 상기 손 위치 추정 장치부의 구성은 상기에서 설명하였으므로 추가적인 설명은 생략하도록 한다. 다만 본 발명에 따른 맨 손 상호 작용 시스템에 있어서, 상기 착용형 디스플레이(10)에 장착된 컬러-깊이 카메라(11, 12) 중 상기 근거리 카메라(11)는 손의 3D 점 군들을 획득하여, 가림효과나 반투명 렌더링을 하는데 사용되며, 상기 원거리 깊이 카메라(12)는 환경의 3D 점 군들을 획득하여, 그림자나 가림 효과를 생성하는데 사용된다. 본 발명에 따른 맨 손 상호 작용 시스템에 있어서, 시각적 피드백은 단일 시점 (monocular) 디스플레이에서 정확한 깊이 인식을 하는데 중요하다, 예를 들어, 도 10의 왼쪽처럼 아무런 시각 피드백을 제공하지 않으면, 손 뒤에 있는 가상 객체가 손 위에 있는 것처럼 보이기 때문에 깊이 인식에 어려움이 있다. 이러한 문제를 해결하기 위해서 손 깊이 맵으로부터 획득한 3D 점군들을 투명하게 렌더링하여 손 뒤에 있는 가상 객체를 가릴 수 있다. 하지만, 도 10의 오른쪽처럼 가상 객체들이 가려져서 위치를 확인하기 어렵다. 따라서, 본 발명은 상기 거리 인지 피드백부(60)를 통해 깊이 인식을 향상하기 위해서 손의 시각적 표현을 개선하고, 환경에 대한 시각적 피드백을 추가하였다. 상기 거리 인지 피드백부(60)는 도 11에 도시된 바와 같이, 사용자의 손 뒤의 대상 객체를 표시하는 반투명 복셀 렌더링부(61), 투명한 복셀 렌더링을 통해, 벽 또는 물리 객체 뒤에 가상 물체를 가리는 투명 복셀 렌더링부(62) 및 회색의 복셀 렌더링을 통해 그림자 효과를 제공하는 회색 복셀 렌더링부(63)를 포함한다. 즉, 손 시각화와 관련하여, 가상 객체가 손의 위치 근처에 있다면, 깊이 테스트에 따라 손 가림 효과가 자연스럽게 이뤄지도록 하였다. 그러나 가상 객체가 원거리에 있는 경우, 사용자가 가상객체를 선택하였을 때, 상기 반투명 복셀 렌더링부(61)을 통해 손을 반투명하게 시각화하여 손에 의해 가려지는 객체의 영역이 약간 어둡게 보일 수 있도록 하였다. 이렇게 하면 가상 객체가 손 뒤에 있는지 앞에 있는지 알 수 있으며, 손에 의해 가려지는 객체의 위치도 확인할 수 있다. 도 12는 본 발명의 일 실시 예에 따른 머리 착용형 디스플레이 기반 증강현실 환경에서 맨 손 상호작용 시 사용자의 시각적 거리 인지 향상 방법에 있어서, 깊이 인지 향상을 위한 시각적 피드백 관련 화면 예시도이다. 도 12에 도시된 바와 같이, 상기 투명 복셀 렌더링부(62)는 환경의 가림효과를 생성하기 위해 원거리 깊이 카메라에서 얻은 3 차원 점 군을 이용한다. 환경에 투명한 복셀 렌더링을 통해, 벽 또는 물리 객체 뒤에 가상 물체를 자연스럽게 가릴 수 있다. 본 발명에 있어서, 상기 회색 복셀 렌더링부(63)의 환경의 그림자 효과는 앞선 투명 복셀의 색상을 변경하는 방법으로 생성하며, 이것은 조작 객체의 형태를 5 개의 면 (정면, 위, 아래, 왼쪽, 오른쪽) 에 투영하여 실시간으로 생성한다. 또한 정밀한 조작을 위해 가상의 가이드라인 선들이 조작 객체의 위치를 기준으로 렌더링한다. 가이드 라인들 역시 착용형 AR 공간의 5개의 면에 수평 방향과 수직 방향으로 연결한다. 도 13은 본 발명의 일 실시 예에 따른 머리 착용형 디스플레이 기반 증강현실 환경에서 맨 손 상호작용 시 사용자의 시각적 거리 인지 향상 방법에 있어서, 반 투명 회색 그림자 및 가이드 라인 관련 화면 예시도이다. 본 발명은 사용자가 가상 객체를 선택하였을 때, 손을 반투명하게 시각화하여 손에 의해 가려지는 객체의 영역의 색상을 변화시킨다. 이로 인해, 가상 객체가 손 뒤에 있는지 앞에 있는지 알 수 있으며, 손에 의해 가려지는 객체의 위치도 확인할 수 있다. 도 14은 본 발명의 일 실시 예에 따른 머리 착용형 디스플레이 기반 증강현실 환경에서 맨 손 상호작용 시 사용자의 시각적 거리 인지 향상 방법에 있어서, 환경 가림 효과 관련 반투명한 손 렌더링에 관한 예시도이다. 이처럼 본 발명은 사용자가 머리 착용형 디스플레이를 착용한 증강 현실 환경에서 맨손으로 가상 3D 객체를 조작할 때, 거리 인지 향상을 위한 시각적 피드백을 제안한다. 손 뒤의 대상 객체를 자연스럽게 보여주기 위해 사용자의 손을 반 투명한 복셀로 렌더링하는 방법, 환경의 자연스러운 가림효과를 위한 투명한 복셀 렌더링, 그리고 그림자 효과를 위한 회색의 복셀 렌더링을 제안한다. 상기와 같이 본 발명에 따른 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치 및 방법, 이를 이용한 맨 손 상호작용 시스템에 관한 동작이 이루어질 수 있으며, 한편 상기한 본 발명의 설명에서는 구체적인 실시 예에 관해 설명하였으나 여러 가지 변형이 본 발명의 범위를 벗어나지 않고 실시될 수 있다. 따라서 본 발명의 범위는 설명된 실시 예에 의하여 정할 것이 아니고 청구범위와 청구범위의 균등한 것에 의하여 정하여져야 할 것이다. The present invention relates to a technology by which a user can manipulate a virtual 3D object with his/her bare hands in a wearable augmented reality (AR) environment and, more particularly, to a technology for Discovering, in a space, three-dimensional positions of a pair of cameras mounted to a wearable display, and a three-dimensional object of a user's hand using distance input data of an RGB-D camera without an apparatus, which is installed in the space (environment), for tracking a hand or a camera, and enabling a user's bare handed interaction on the basis of discovered positions. 사용자의 머리에 착용되어, 전방을 영상 촬영하는 컬러-깊이 카메라를 장착하고, 공간 정합된 증강현실 영상을 사용자에 제공하는 착용형 디스플레이; 컬러-깊이 카메라에서 획득한 깊이맵 영상으로부터, 손 객체를 분리하는 손 객체 분리부 및 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하여 손 위치를 획득하는 손 위치 획득부를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치. 제1항에 있어서, 상기 컬러-깊이 카메라는 손을 감지하고, 장거리 카메라는 환경으로부터 카메라 쌍의 위치를 알아내고, 물리적인 세계와 가상세계 사이의 스케일 정보를 보정하는 근거리 깊이 카메라 및 환경으로부터 카메라 쌍의 위치를 획득하고, 현실과-가상 공간 내의 스케일 파라메터를 보정하는 장거리 깊이 카메라를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치. 제1항에 있어서, 상기 손 객체 분리부는 영상의 노이즈를 제거하고, 최대 크기의 윤곽 (Contour)을 획득하는 윤곽 획득부 및 거리 변환 (Distance transform)를 수행하여, 가장 높은 강도를 가지는 화소의 픽셀 좌표를 손바닥의 중심 위치로 정의하는 거리 변환부를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치. 제1항에 있어서, 상기 손 위치 획득부는 이미지 좌표계로부터 카메라 좌표계로 손의 픽셀 좌표를 역투영(Back projection)하여 카메라 좌표계를 기준으로 손의 3차원 위치를 계산하고, SLAM 기반의 카메라 추적 방법으로 손 위치를 추적하는 손 좌표 획득부 및 로컬 좌표계에 대한, SLAM(Scanning Laser Acoustic Microscope) 기반의 가상 카메라의 거리와 깊이 카메라의 거리의 비율을 계산하여 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하는 손 정합부를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치. 제1항에 있어서, 상기 손 위치 획득부와 연결되어, 사용자의 손의 동작에 따라 가상 3D 객체를 선택하고 조작하는 객체 조작부를 더 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 장치. (a) 컬러-깊이 카메라를 통해 사용자 전방을 영상 촬영하는 단계; (b) 손 객체 분리부를 이용하여 컬러-깊이 카메라에서 획득한 깊이맵 영상으로부터, 손 객체를 분리하는 단계; (c) 손 위치 획득부를 이용하여 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하여 손 위치를 획득하는 단계; (d) 착용형 디스플레이를 통해 정합된 영상을 제공하는 단계 및 (e) 객체 조작부를 이용하여, 사용자의 손의 동작에 따라 가상 3D 객체를 선택하고 조작하는 단계를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 방법. 제1항에 있어서, 상기 (a) 단계의 컬러-깊이 카메라는 손을 감지하고, 장거리 카메라는 환경으로부터 카메라 쌍의 위치를 알아내고, 물리적인 세계와 가상세계 사이의 스케일 정보를 보정하는 근거리 깊이 카메라 및 환경으로부터 카메라 쌍의 위치를 획득하고, 현실과-가상 공간 내의 스케일 파라메터를 보정하는 장거리 깊이 카메라를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 방법. 제1항에 있어서, 상기 (b) 단계는 (b-1) 윤곽 획득부를 이용하여 분리된 손 객체 영상의 노이즈를 제거하고, 최대 크기의 윤곽 (Contour)을 획득하는 단계 및 (b-2) 거리 변환부를 이용하여 거리 변환 를 수행하여, 가장 높은 강도를 가지는 화소의 픽셀 좌표를 손바닥의 중심 위치로 정의하는 단계를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 방법. 제1항에 있어서, 상기 (c) 단계는, (c-1) 손 좌표 획득부를 이용하여 이미지 좌표계로부터 카메라 좌표계로 손의 픽셀 좌표를 역투영(Back projection)하여 카메라 좌표계를 기준으로 손의 3차원 위치를 계산하고, SLAM(Scanning Laser Acoustic Microscope) 기반의 카메라 추적 방법으로 손 위치를 추적하는 단계 및 (c-1) 손 정합부를 이용하여 로컬 좌표계에 대한, SLAM 기반의 가상 카메라의 거리와 깊이 카메라의 거리의 비율을 계산하여 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하는 단계를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 손 위치 추정 방법. 컬러-깊이 카메라를 통해 촬영된 영상에서 카메라 좌표계를 기준으로 손의 3D 특징을 추출하고 AR 공간의 로컬 참조 좌표계를 기준으로 가상 손 모델을 사용자의 손 위치에 정합하여 제공하는 손 위치 추정 장치부 및 상기 손 위치 추정 장치부와 연결되어, 사용자의 시각적 거리를 인지하여 상호작용 피드백을 제공하는 거리 인지 피드백부를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템. 제10항에 있어서, 상기 손 위치 추정 장치부는 사용자의 머리에 착용되어, 전방을 영상 촬영하는 컬러-깊이 카메라를 장착하고, 공간 정합된 증강현실 영상을 사용자에 제공하는 착용형 디스플레이; 컬러-깊이 카메라에서 획득한 깊이맵 영상으로부터, 손 객체를 분리하는 손 객체 분리부 및 현실 공간에서의 손 위치를 계산하여 가상 손 모델을 사용자 손 위치에 정합하여 손 위치를 획득하는 손 위치 획득부를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템. 제11항에 있어서, 상기 거리 인지 피드백부는 사용자의 손 뒤의 대상 객체를 표시하는 반투명 복셀 렌더링부; 투명한 복셀 렌더링을 통해, 벽 또는 물리 객체 뒤에 가상 물체를 가리는 투명 복셀 렌더링부 회색의 복셀 렌더링을 통해 그림자 효과를 제공하는 회색 복셀 렌더링부를 포함하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템. 제12항에 있어서, 상기 회색 복셀 렌더링부는 상기 투명 복셀 렌더링부에서 생성된 투명 복셀의 색상을 변경하여 그림자효과를 생성하며 조작 객체의 형태를 구성하는 다수 개의 면 중 적어도 어느 하나 이상의 면에 투영하는 것을 특징으로 하는 머리 착용형 컬러 깊이 카메라를 활용한 맨 손 상호작용 시스템.