Verfahren und Vorrichtung zur Bildverarbeitung durch Demosaicing

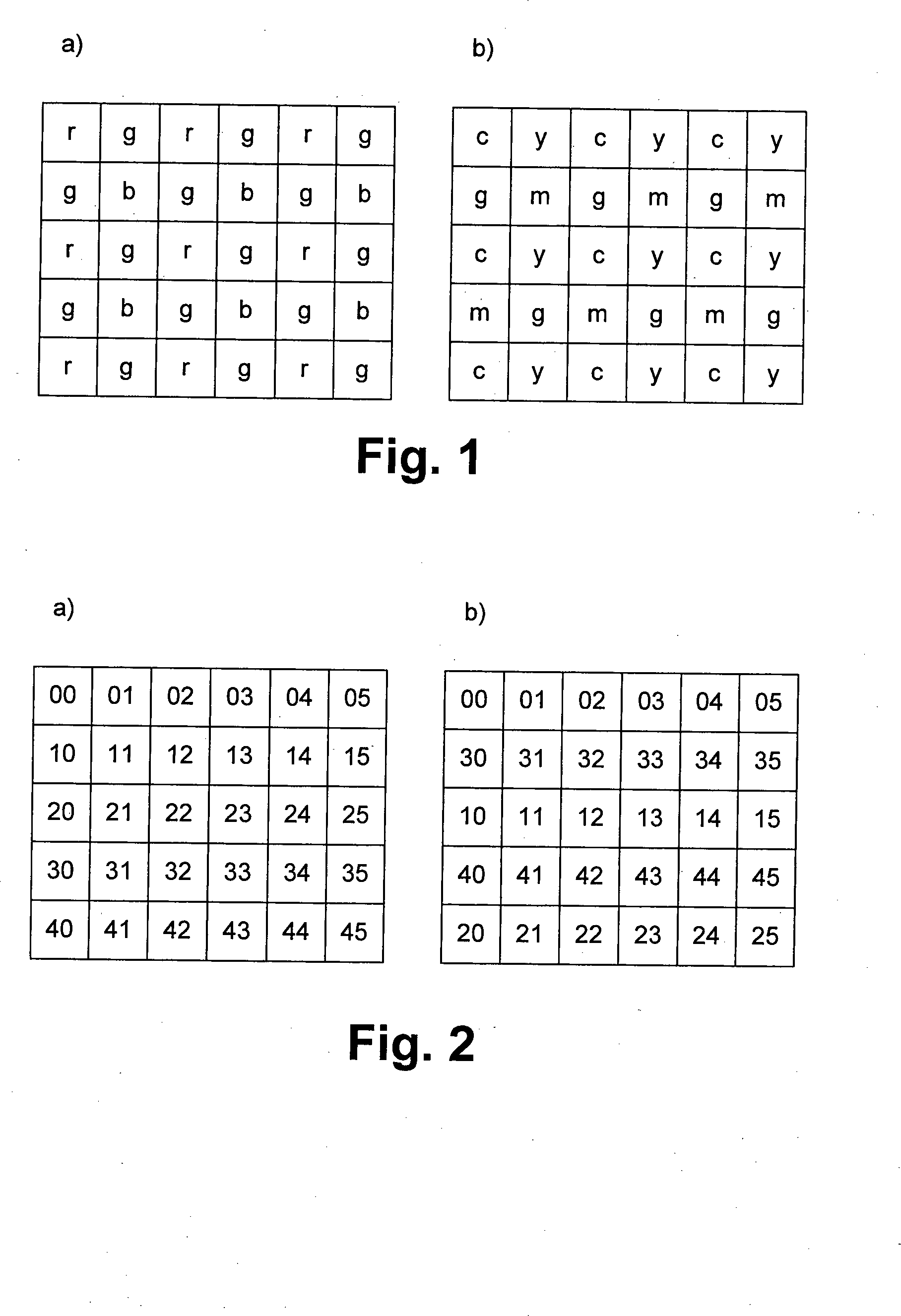

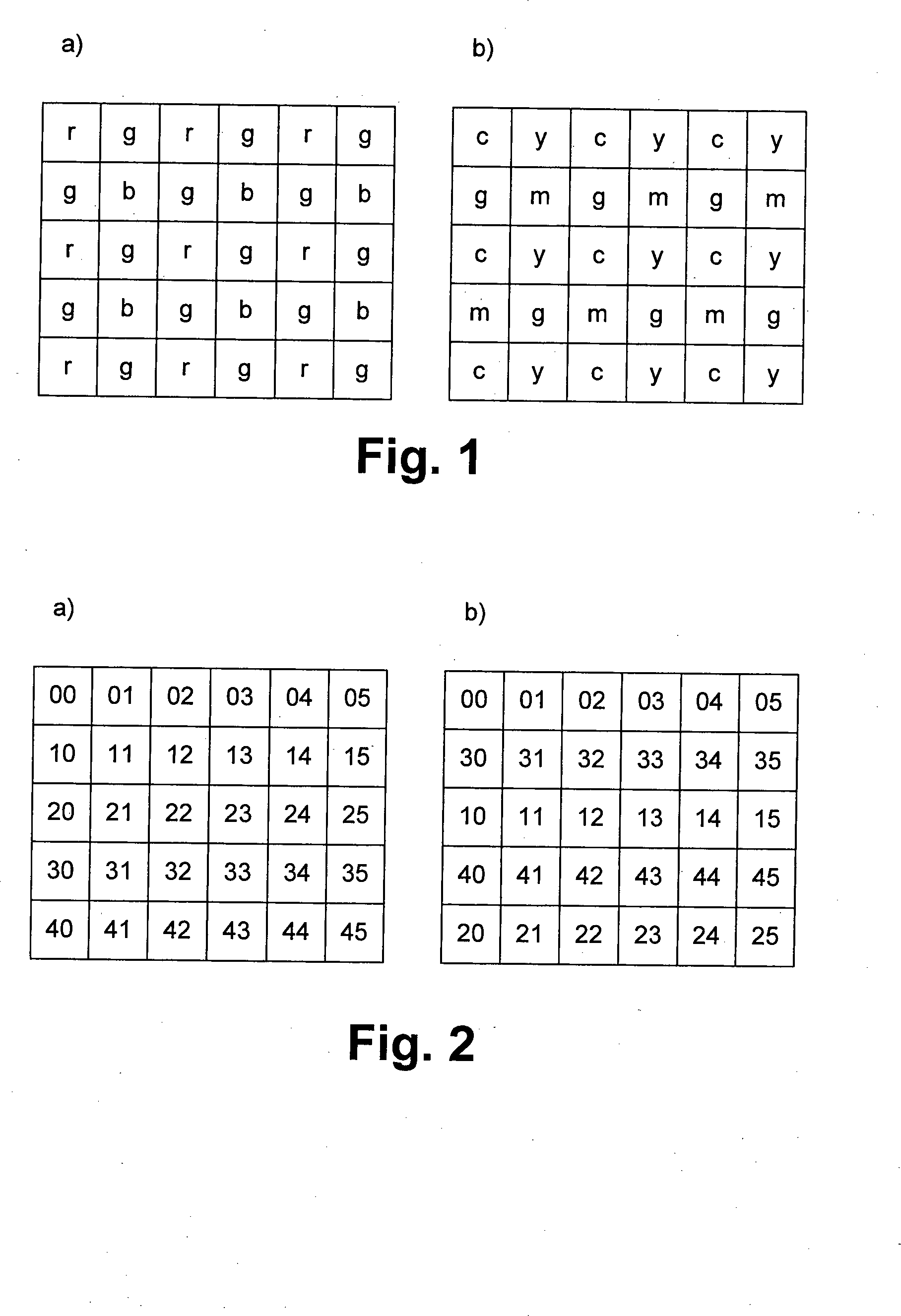

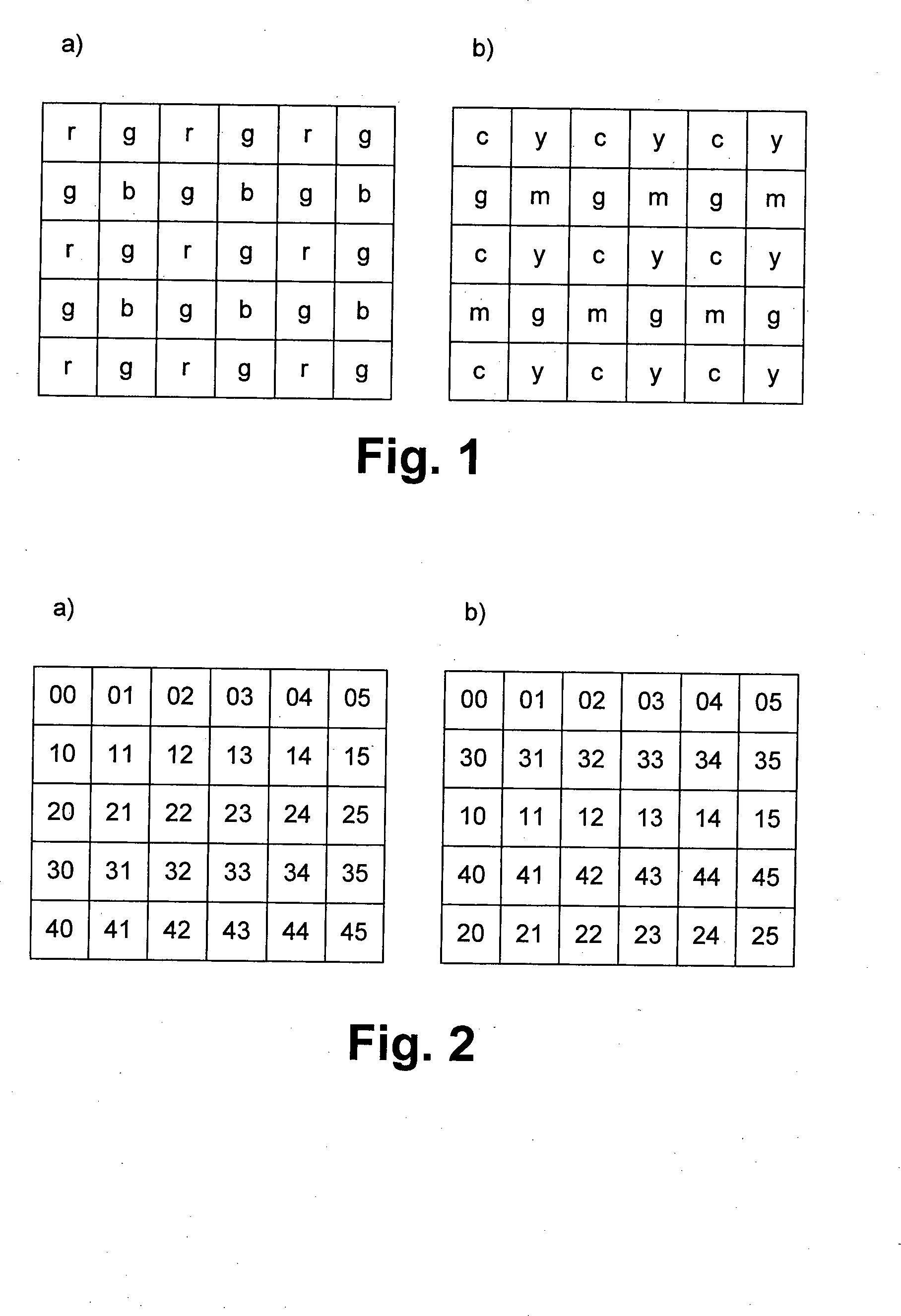

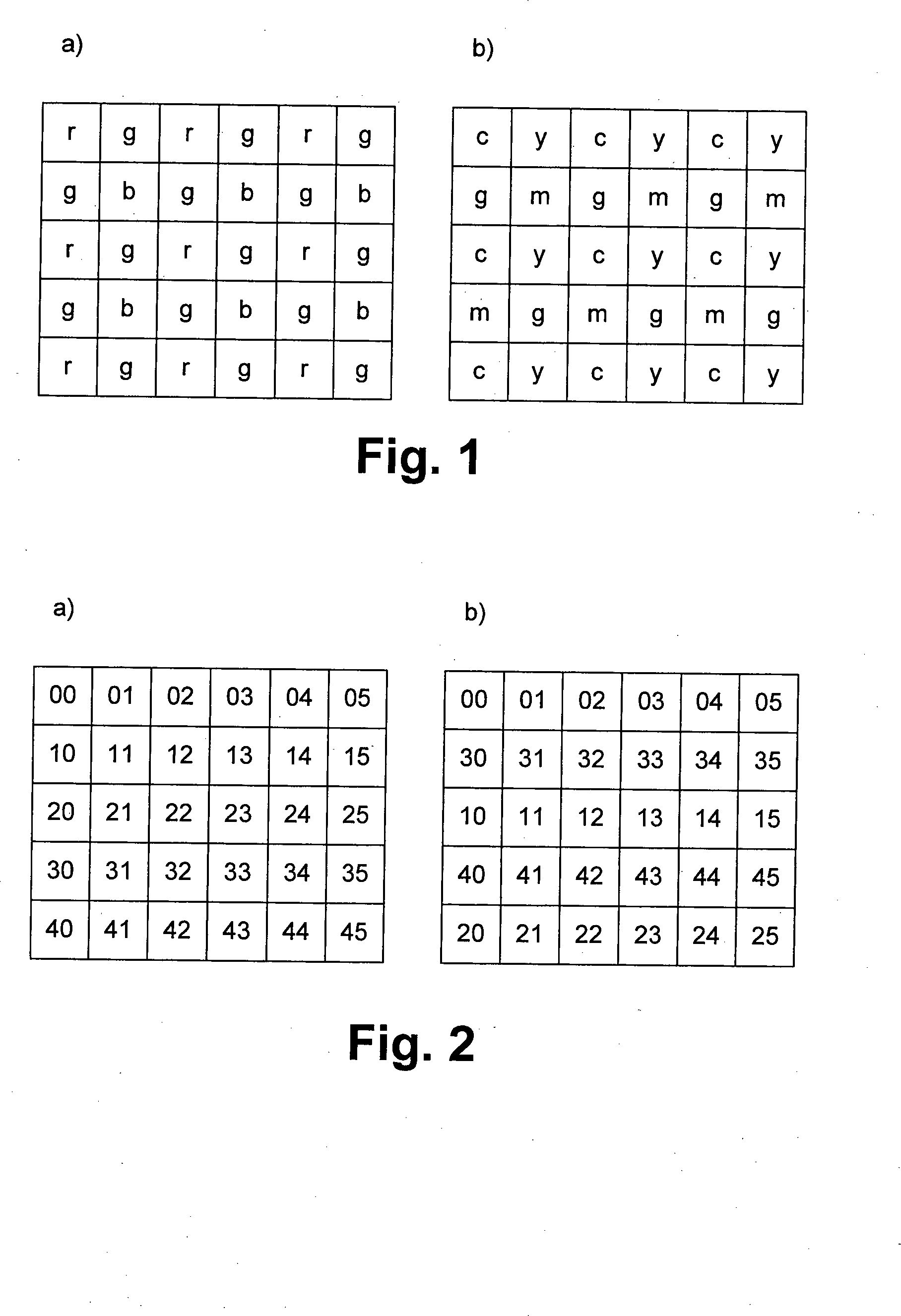

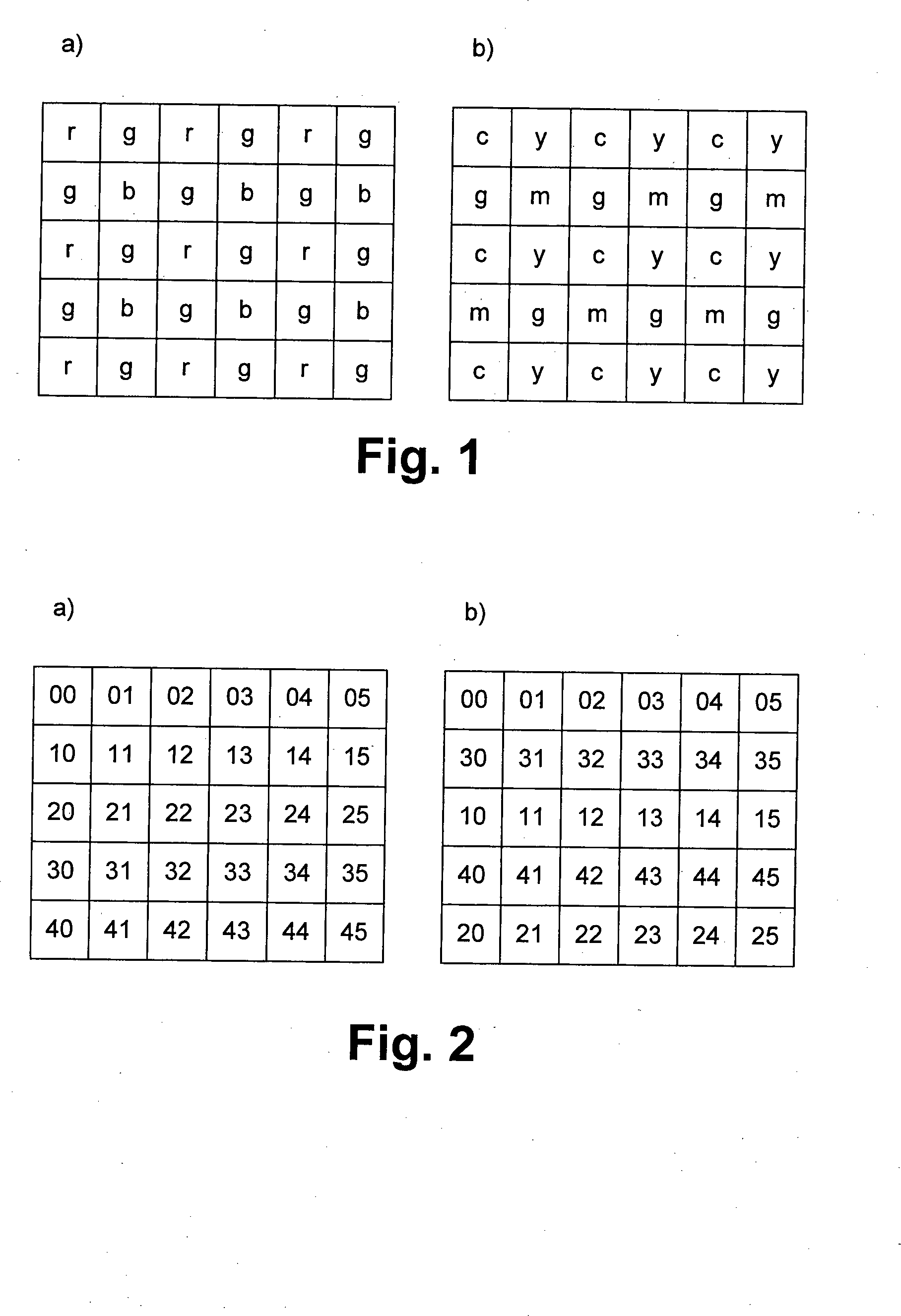

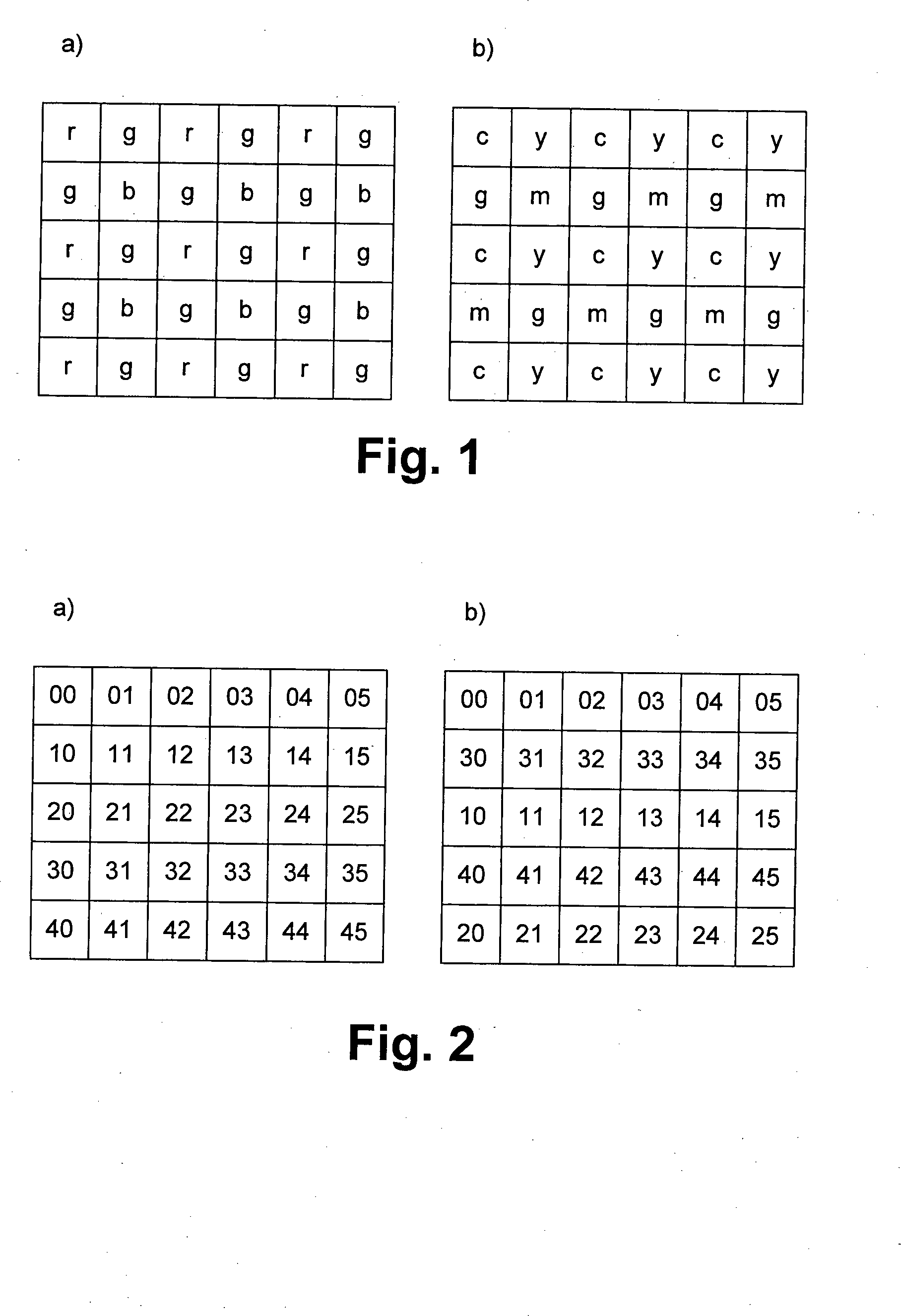

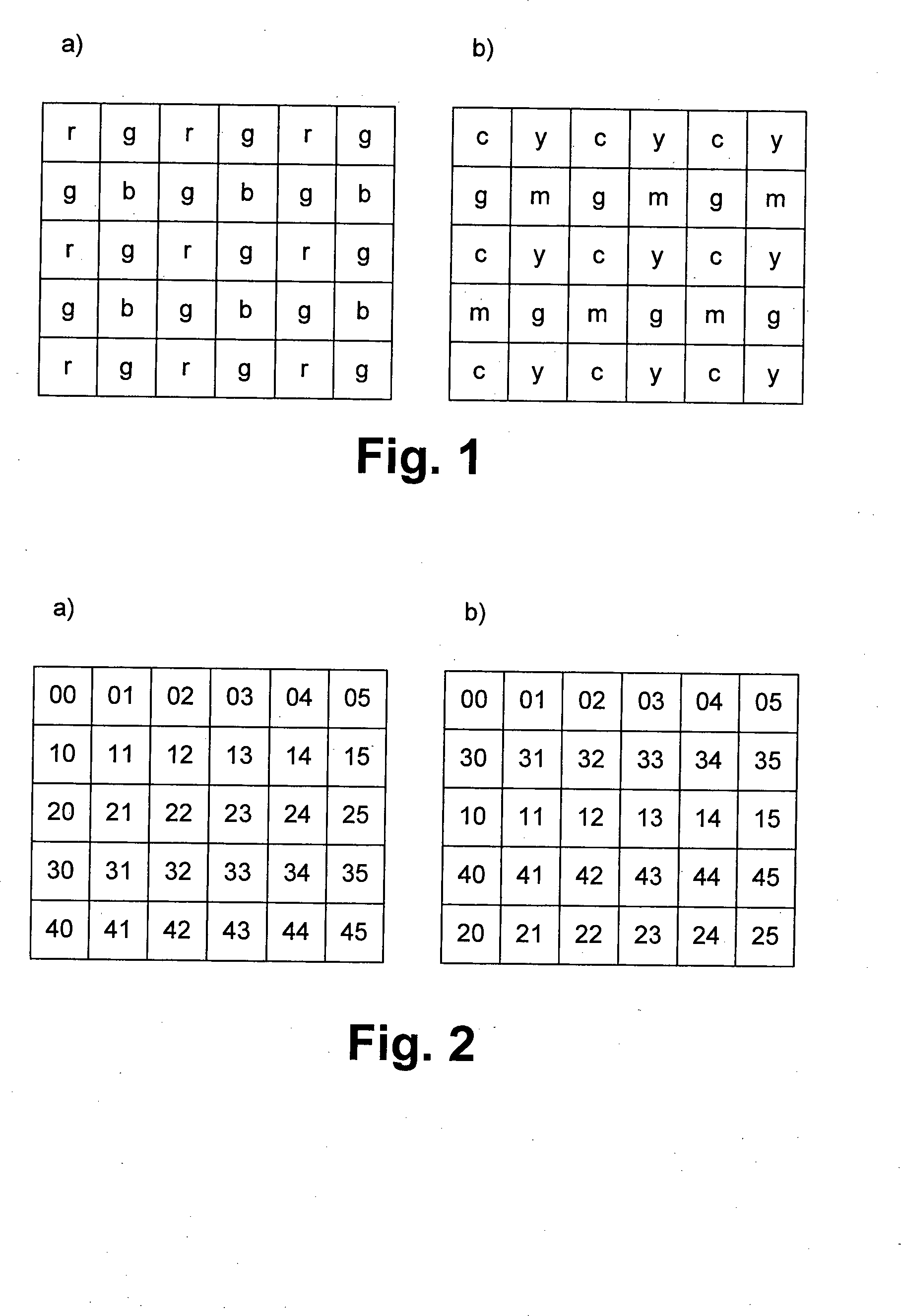

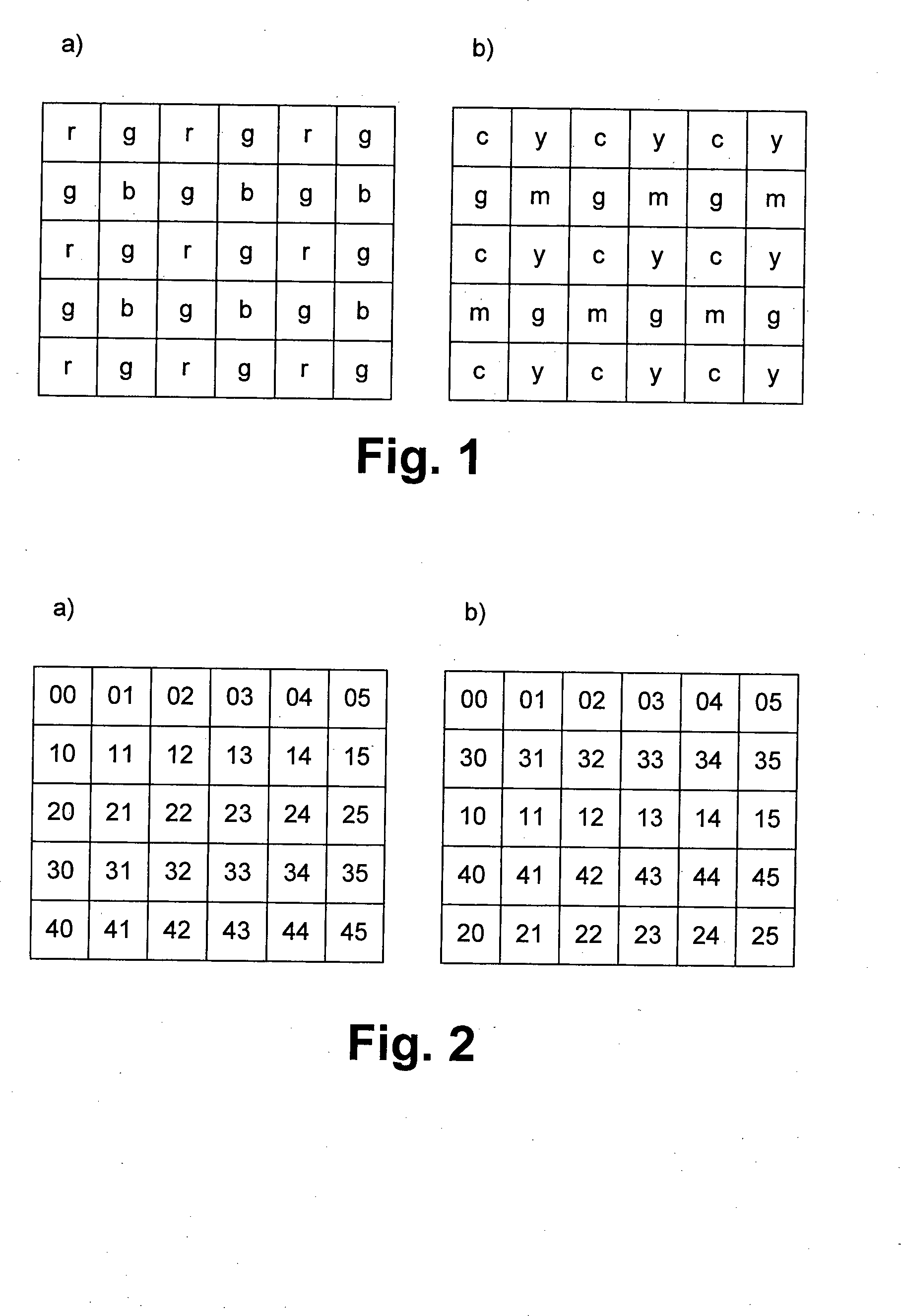

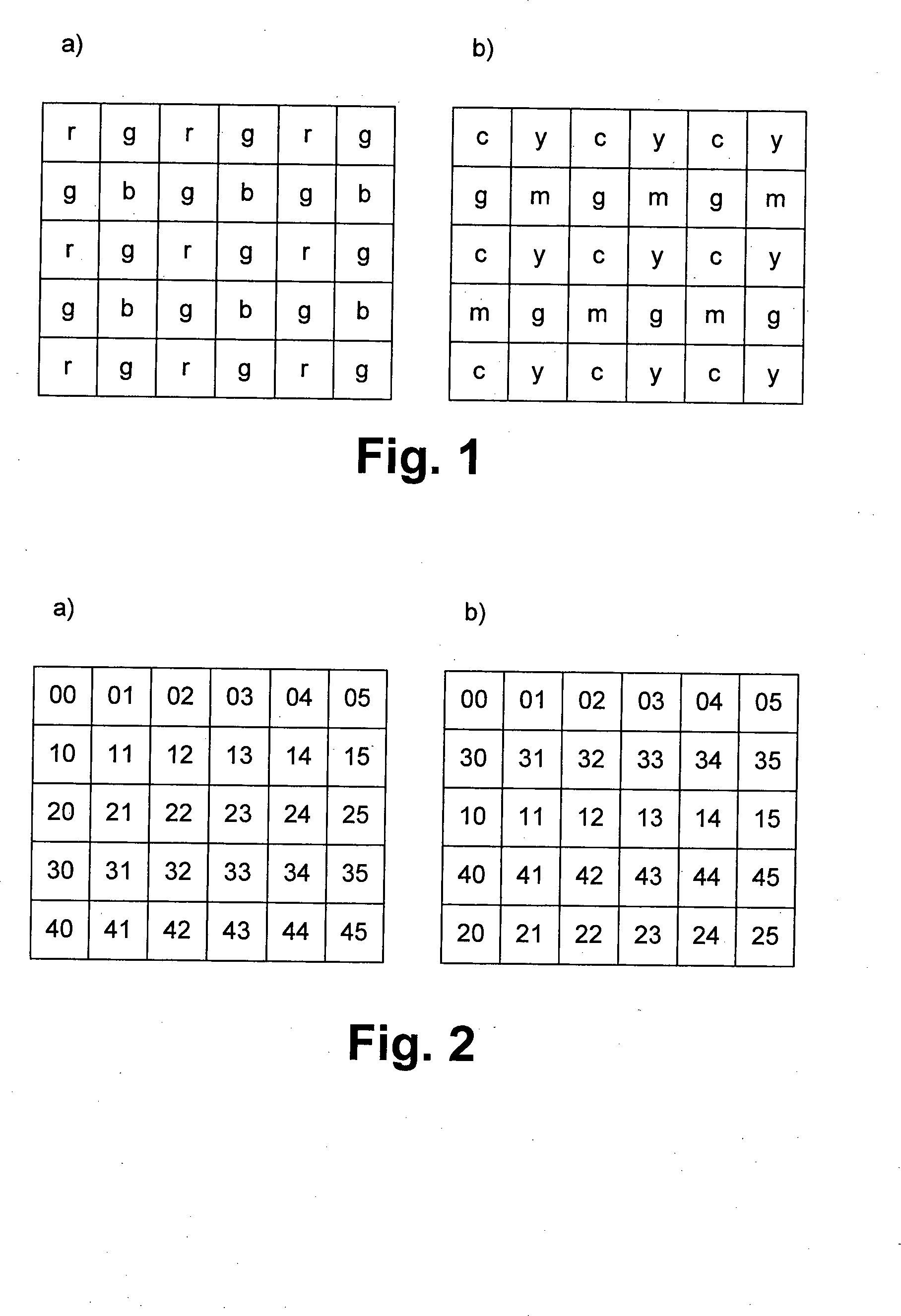

Die Erfindung betrifft ein Verfahren und eine Vorrichtung zur Bildverarbeitung, wobei Rohdaten eines Bildsensors mittels eines Mosaikfilters in ein Farbbild umgewandelt werden, bei dem für jeden Bildpunkt ein Farbvektor in einem Farbraum vorliegt. Elektronische Bildverarbeitungsgeräte, wie bspw. Kameras odgl., werden für zahlreiche Aufgaben eingesetzt, z. B. in automatisierten Produktionsprozessen oder zur Überwachung von Objekten. Grundsätzlich wird dabei ein Objekt mittels einer Optik, z. B. mittels eines Objektives, auf einem Bildsensor abgebildet. Die Signale des Bildsensors werden von einer Bildverarbeitungseinheit umgewandelt und über eine Schnittstelle, z. B. ein Kabel, eine Funkverbindung oder ein Speichermedium, übertragen. Es werden analoge Bildverarbeitungsgeräte von digitalen Bildverarbeitungsgeräten unterschieden. Analoge Bildverarbeitungsgeräte verfügen über mindestens eine Schnittstelle, über die mindestens ein analoges Bildsignal übertragen wird, z. B. mittels der bekannten Normen für Bildsignale NTSC (National Television Systems Committee), SECAM (Séquentiel couleur à mémoire) oder PAL (Phase Alternating Line). Ein solches analoges Bildsignal weist mindestens eine analoge Größe zur Übertragung der Information auf, z. B. eine Ladungsmenge, einen Strom, eine Spannung, eine Frequenz oder eine Phase. Digitale Bildverarbeitungsgeräte hingegen übertragen Signale als Menge oder Folge digitaler Bits, welche jeweils aus Zuständen Null oder Eins bestehen. Auch für die Übertragung digitaler Bildsignale gibt es Normen, z. B. H.242 oder MPEG-3 (Moving Picture Experts Group). Bildsensoren beinhalten in der Regel eine regelmäßige Anordnung lichtempfindlicher Elemente, welche als Pixel bezeichnet werden. Bildsensoren für Farbkameras sind zumeist mit Mosaikfiltern ausgestattet, wie bspw. in der Es sind auch Bildsensoren für eine fortlaufende Bildausgabe bekannt, die im Fachjargon Als ”Progressiv Scan” bezeichnet werden. Hierbei werden in einem Auslesevorgang alle Pixel in einer vorgegebenen Reihenfolge ausgelesen. Das ausgelesene Bild weist also ebenso viele Bildpunkte auf, wie der zugehörige Bildsensor Pixel hat. Diese Art des Auslesens entspricht der Übertragung digitaler Bilddaten und ist daher besonders vorteilhaft für digitale Bildverarbeitungsgeräte. Auch sind solche Bildsensoren bekannt, die für eine halbbildweise Bildausgabe vorgesehen sind. Diese werden vom Fachmann als ”interlaced” bezeichnet. Hierbei werden in jedem Auslesevorgang nur halb so viele Bildpunkte ausgelesen, wie der Bildsensor Pixel hat. Ein vollständiges Bild, welches ebenso viele Bildpunkte wie Pixel aufweist, benötigt also zwei aufeinanderfolgende Auslesevorgänge. Diese Sensoren sind zumeist so ausgeführt, dass in einem ersten Auslesevorgang nur die geraden Zeilen und ein einem zweiten Auslesevorgang nur die ungeraden Bildzeilen ausgegeben werden. Diese Funktionsweise entspricht der Übertragung analoger Bildsignale für z. B. PAL oder NTSC und ist dabei besonders vorteilhaft für analoge Bildverarbeitungssysteme. Es ist bekannt, das Signal benachbarter Pixel bereits im Sensor zusammenzuführen. Dies bezeichnet der Fachmann als ”Binning” bezeichnet (vgl. Es ist bspw. ein CCD Bildsensor bekannt, der einen CMYG-Mosaikfilter sowie eine interlaced-Auslesestruktur aufweist. Ein bevorzugtes Verfahren zum Betrieb des Bildsensors wird vom Hersteller im zugehörigen Datenblatt angegeben. Dort wird vorgeschlagen, das Bild in ein A-Halbbild und ein B-Halbbild zu unterteilen, welche durch jeweils aufeinander folgende, getrennte Belichtungsvorgänge gewonnen werden. In jedem der Halbbilder wird jeweils vertikales Binning angewandt. Dabei werden die Ladungspakete der Pixel jeweils in einem der Halbbilder mit den oberen und im anderen mit den unteren benachbarten Pixel zusammen geführt. Auf diese Weise sind die Mittelpunkte der den Bildpunkten zugehörigen lichtempfindlichen Flächen im Vergleich der beiden Halbbilder gegeneinander um jeweils eine Pixelzeile verschoben. Das gewonnene Signal lässt sich auf einfache Weise zur Gewinnung eines analogen Videosignals, z. B. NTSC, SECAM oder PAL nutzen. Durch das Binning werden Ladungspakete zusammen addiert, deren zugehörige Pixel jeweils verschiedene Farbfilter aufweisen. So werden z. B. in einem Pixelzeilenpaar fortlaufend c + g und y + m addiert, in einem weiteren Pixelzeilenpaar fortlaufend c + m und y + g. Als Ergebnis liegt ein Bildsignal aus gebinnten Farben cg, ym, cm und yg vor. Aus diesen lassen sich, wie im Datenblatt angegeben, auf einfache Weise die Signale V, U = r – Y und V = b – Y generieren, die für die Synthese eines analogen Videosignals benötigt werden. Digitale Bildverarbeitungsgeräte, wie bspw. Farbkameras, geben üblicherweise fortlaufende Farbbilder aus, bei denen jeder Bildpunkt einen Farbvektor mit mehr als einem Wert zur Beschreibung seiner Farbe aufweist. Da die Pixel von Bildsensoren mit Mosaikfilter nur einen Rohdatenwert zur Verfügung stellen, ist es erforderlich, die fehlenden Werte auf rechnerische Weise zu ermitteln. Die Werte eines Bildpunktes zur Beschreibung einer Farbe können z. B. Primärfarbanteile sein oder Helligkeit, Farbton und Farbsättigung, oder andere Farbvektorkomponenten zur Bezeichnung einer Stelle in einem Farbraum. Ein Verfahren zur rechnerischen Ermittlung solcher fehlender Werte bezeichnet der Fachmann als „Demosaicing”. Verfahren zum Demosaicing der Bilddaten von Bildsensoren mit RGB-Farbfiltern sind bspw aus der Die bekannten Demosaicing-Verfahren für RGB-Bildsensoren lassen sich nicht auf einfache Weise auf CMYG-Bildsensoren mit Binning übertragen. Denn zum ersten besteht der RGB Mosaikfilter aus drei Farben und der CMYG aus vier Farben. Zum zweiten benötigen die bekannten RGB Demosaicing Verfahren jeweils eine Farbinformation, die sich direkt einer Farbe und einem Pixel zuordnen lässt, was bei gebinnten CMYG Farbbilddaten nicht der Fall ist. Bildsensoren mit CMYG-Mosaikfiltern besitzen gegenüber Bildsensoren mit RGB Mosaikfiltern sowohl Vorteile als auch Nachteile, welche je nach Anwendung verschieden zu bewerten sind. Bildsensoren mit CMYG-Mosaikfilter besitzen häufig eine vorteilhaft bessere Lichtempfindlichkeit, da die Filter der Komplementärfarben c, m und y im Allgemeinen für ein breiteres Spektrum optischer Frequenzen transparent sind als vergleichbare RGB-Farbfilter. Diese bessere Lichtempfindlichkeit ist vor allem für Kameras wichtig, die sowohl bei Tageslicht als auch im Nachtsichtbetrieb eingesetzt werden, wie dies z. B. bei Überwachungskameras im Außeneinsatz häufig der Fall ist. Nachteilig an CMYG-Mosaikfiltern ist ihre teils schlechtere Farbtrennung im Vergleich zu RGB-Mosaikfiltern. Auch kann ein Interesse bestehen, analoge Kameras mit Bildsensoren mit CMYG-Mosaikfilter durch digitale Kameras mit einem baugleichen Bildsensor zu ersetzen. Digitale Kameras bieten den Vorteil, dass sich ihre Bilder verlustfrei übertragen und speichern lassen. Die Verwendung eines baugleichen Bildsensors bei einem Austausch einer analogen Kamera gegen eine digitale Kamera vermeidet auf vorteilhafte Weise eine Anpassung der Optik, der Ansteuerung oder der Auswertung. Das Bild ist also das gleiche, jedoch die Übertragung verbessert sich. Es gibt Bildsensoren mit CMYG-Mosaikfilter, die preiswerter sind als ein sonst baugleicher Bildsensor mit einem RGB-Mosaikfilter. Auch das kann eine Motivation erklären, eine Digitalkamera mit einem Bildsensor mit CMYG Mosaikfilter auszurüsten. Der Erfindung liegt die Aufgabe zugrunde, ein digitale Bildverarbeitungsgerät mit einem Bildsensor mit CMYG-Mosaikfilter zur Verfügung zu stellen und ein Verfahren zur Bildverarbeitung mittels Demosaicing für Bildsensoren mit CMYG-Mosaikfilter und Binning. Diese Aufgabe wird erfindungsgemäß gelöst durch eine Vorrichtung nach Anspruch 1 und ein Verfahren nach Anspruch 16. Bevorzugte Ausführungsformen der Erfindung werden anhand der beiliegenden Figuren näher erläutert. Es zeigen: Gemäß einem bevorzugten Ausführungsbeispiel ist ein Bildsensor mit CMYG-Mosaikfilter für halbbildweise Bildausgabe eingerichtet und wird im Binning betrieben. Hierdurch werden auf vorteilhafte Weise Farbartefakte vermieden. Letzteres wird nachfolgend erläutert. Entsteht ein Streifenartefakt im Rohbild eines Bildsensors mit CMYG-Mosaikfilter ohne Binning, so weist ein rekonstruiertes Farbbild eines bewegten, Objekts 121 nachteilige Farbsäume 122 und 123 auf. Unter einem Rohbild wird hier das Bild vor einer Farbrekonstruktion verstanden. Die Farbsäume entstehen dadurch, dass jedes Halbbild aufgrund des Mosaikfilters nur zwei Filterfarben aufweist, während zur Bestimmung einer Farbe mindestens drei, vorzugsweise jedoch vier solcher Farben benötigt werden. Diese können folglich aus zwei aufeinanderfolgend aufgenommenen Halbbildern zusammengesetzt werden, in denen jedoch das bewegte Objekt eine andere Position aufweist. Ohne weitere Maßnahmen werden also für einen Bildpunkt nicht zusammengehörende Farben einander zugeordnet, was zu Farbsäumen mit falschen Farben führt. Ein unbewegtes Objekt 120 weist folglich keine Farbsäume auf. Es ist somit vorteilhaft, bei halbbildweiser Bildausgabe Binning einzusetzen. Für das Demosaicing wird bei halbbildweiser Bildausgabe und Binning für mindestens jedes Halbbild ein Helligkeitsbild ermittelt. In diesem Helligkeitsbild ist jeder Bildposition ein Helligkeitswert Y zugeordnet. Wird ein Binning auf das Bild eines Bildsensors mit CMYG-Mosaikfilter angewandt, so entstehen dadurch Ladungspakete, die jeweils Farbpaaren zugeordnet sind, z. B. cg, ym, cm und yg. Ein Helligkeitssignal Y lässt sich aus dem Mittelwert bzw. der Summe der Werte benachbarter gebinnter Pixel ermitteln. Hierbei macht es keinen Unterschied ob eine Summe ermittelt wird von gebinnten Pixeln gc + ym oder von gebinnten Pixeln cm + yg. Da das Binning seinerseits eine Addition der beteiligten Pixel ist, ergibt sich in beiden genannten Fällen die Gesamtsumme c + m + y + g. Auf eine solche Weise lässt sich für jede 2×2-Gruppe von Pixeln ein Y-Wert ermitteln, denn beim genannten CMYG-Mosaikfilter umfasst jede 2×2-Gruppe von Pixel ohne Rücksicht auf die Reihenfolge genau die Farben c, y, g und m. Auf solche Weise ist es unter Vernachlässigung des Sensorrandes möglich, genau so viele Y-Werte zu ermitteln, wie es Pixel gibt. Der Schwerpunkt einer solchen Berechnung liegt zwischen den Sensorspalten. Für nachfolgende Berechnungen ist es wünschenswert, dass der Schwerpunkt genau in der Mitte einer Sensorspalte liegt. Dies kann dadurch erreicht werden, dass zur Hälfte eines gebinnten Farbwertes, z. B. cg, ym, cm oder yg, jeweils ein Viertel des links benachbarten und des rechts benachbarten gebinnten Farbwertes ym, cg, yg oder cm addiert werden. Dadurch kann eine für nachgelagerte Rechenschritte nachteilige horizontale Phasenverschiebung zwischen dem Y-Bild und den Pixelpositionen um eine halbe Pixelbreite vermieden werden. Für das Demosaicing wird für jede Pixelposition ein Wert jedes gebinnten Farbwertes (z. B. cg, ym, cm, yg) ermittelt. Dadurch verbessert sich nach nachfolgenden Reche schritten der Bildeindruck auf vorteilhafte Weise. Der Eindruck der Bildschärfe nimmt zu und Farbartefakte an Kanten werden vermieden. Ein gebinnter Farbwert von beispielsweise vier gebinnten Farbwerten cg, ym, cm und yg wird nur an jeder vierten Stelle des gebinnten Bildes ermittelt. Dabei liegt der gebinnte Farbwert nur in jeder zweiten gebinnten Zeile und nur in jeder zweiten Spalte vor. Dies entspricht jeweils einer Halbierung der Abtastfrequenz in horizontaler und in vertikaler Richtung gegenüber dem Raster der gebinnten Pixel. Jeder andere Farbwert liegt ebenfalls mit der horizontal und vertikal halbierten Abtastfrequenz vor, jedoch mit einer anderen Abtastphase, welche einer anderen räumlichen Position im Bild entspricht. Wendet man auf diese Situation eine herkömmliche Bildverarbeitungslehre gemäß dem Stand der Technik an, so werden räumlich nicht exakt einander zugeordnete Farbinformationen verknüpft, was auf nachteilige Weise zu Farbartefakten, z. B. zu Fehlfarben an z. B. Linien oder Kanten führen kann. Wird hingegen für jeden Bildpunkt ein Farbwert jeder gebinnten Farbe ermittelt, so können in nachfolgenden Rechenschritten solche Farbwerte miteinander kombiniert werden, die zu ein und dem selben Bildpunkt gehören. Dies vermeidet die genannten Fehlfarben an Linien oder Kanten auf vorteilhafte Weise. Bei der Ermittlung fehlender Werte gebinnter Farben wird der fehlende Wert aus den bekannten Werten nächster Nachbarn rechnerisch ermittelt. In Farbbildern sind Farbflächen sehr viel häufiger als Kanten. Dadurch weisen benachbarte Pixel häufig gleiche oder ähnliche Farbwerte auf. Die Verwendung der Werte benachbarter Pixel hat darüber hinaus den Vorteil, dass bei der Implementierung in sogenannte Pipeline-Operatoren, z. B. in ein Field Programmable Gate Array (FPGA), nur wenige Zeilen bzw. Werte zwischengespeichert werden müssen. Die Ermittlung fehlender Werte gebinnter Farben verwendet eine Interpolation, vorzugsweise eine Mittelwertbildung. Besonders bei der Verwendung von Pipeline-Operatoren lässt sich eine solche Mittelwertbildung mit sehr geringem Aufwand durchführen und sie liefert gute Ergebnisse. Vorzugsweise werden fehlende Werte solcher Pixel, die nur diagonale nächste Nachbarn mit bekannten Werten der gesuchten gebinnten Farbe aufweisen, durch Mittelwertbildung aller diagonalen nächsten Nachbarn mit bekannten Werten der gesuchten gebinnten Farbe ermittelt. Bei der Ermittlung fehlender Werte gebinnter Farben wird auf rechnerische Weise der hochfrequenten Helligkeitsanteil HY in dem Helligkeitsbild verwendet. Die Frequenzantwort 131 aller Farbinformationen UV liegt jeweils mit halber Abtastfrequenz vor gegenüber der Frequenzantwort 130 der Helligkeitsinformationen Y. Des Weiteren lässt sich auf vorteilhafte Weise eine korrigierte Frequenzantwort 132 für Farbinformationen nachbilden, indem die vorhandene Frequenzantwort mit halber Abtastfrequenz, welche die niedrigen Frequenzanteile enthält, um den Hochfrequenzanteil HY 133 der Helligkeitsinformation 130 erweitert wird. Hierdurch lässt sich auf vorteilhafte Weise die Ortsauflösung im Ergebnisbild verbessern, wodurch sich ein Eindruck besserer Bildschärfe ergibt und Bilddetails häufig besser erkannt werden können. Die Ermittlung des hochfrequenten Helligkeitsverlaufes erfolgt mittels Subtraktion des Mittelwertes der bekannten Helligkeitswerte nächster Nachbarn vom Helligkeitswert des fraglichen Pixels. Es gibt dabei nur solche fehlenden Werte, für die nächste Nachbarn mit bekannten Helligkeitswerten vorliegen. Es kommen nur solche Pixel vor, bei denen die nächsten Nachbarn mit bekannten Helligkeitswerten horizontal benachbart, vertikal benachbart oder in den vier diagonalen Richtungen benachbart sind. Darüber hinaus ist es vorteilhaft, zur Hochpassfilterung eine solche Berechnungsmethode zu verwenden, die phasenneutral ist. Dadurch wird eine nachteilige Verschiebung des hochpassgefilterten Bildes nach links, rechts, oben, unten oder eine andere Richtung vermieden. Die hier genannte Lösung besitzt diese Eigenschaften. Zur Ermittlung des hochfrequenten Helligkeitsverlaufes wird einer der nachfolgend genannten Filterprinzipien verwendet: Die Ermittlung des Hochfrequenzanteiles erfolgt dabei ebenfalls jeweils unter Berücksichtigung der erforderlichen Raumrichtung. Die genannten Filter lassen sich auf vorteilhaft einfache Weise in einem Prozessor, einem digitalen Signalprozessor (DSP) oder einem FPGA implementieren. Sie sind alle phasenneutral. Zur Berechnung eines fehlenden gebinnten Farbwertes werden der durch Interpolation, vorzugsweise Mittelung, benachbarter gleicher Farbwerte ermittelte Wert und der hochfrequente Helligkeitswert HY addiert. Hierdurch lässt sich ein besonders gutes Interpolationsergebnis erzielen. Auch lässt sich durch Simulation nachweisen, dass das hierdurch erzielte Berechnungsergebnis besonders geringe Abweichungen gegen über einem erwarteten Ergebnis zeigt. Aus vier gebinnten Farbwerten eines Pixels werden zwei Farbwerte U und V auf rechnerische Weise ermittelt. Da bereits ein Helligkeitswert Y vorliegt, lässt sich so auf besonders einfache Weise ein Wert in einem Farbraum ermitteln, nämlich dem YUV-Farbraum. Auf die vier gebinnten Farbwerte wird ein Weißabgleich angewendet, vorzugsweise dergestalt, dass die Farbwerte jeweils mit einem Korrekturwert multipliziert werden. Durch den Weißabgleich werden unbunte Farben im Bild von der Kamera als unbunte Farben wiedergegeben. Dadurch werden nachteilige Farbstiche weißer oder grauer Bildinhalte auf vorteilhafte Weise vermieden. Ebenso werden Fehlfarben anderer Bildinhalte auf vorteilhafte Weise vermieden. Die Ermittlung der Farbwerte U und Verfolgt dergestalt, dass die Differenzen der weißabgeglichenen gebinnten Farbwerte cg und ym, bzw. cm und yg ermittelt werden und aus den beiden Differenzen durch Linearkombination die Farbwerte U und Vermittelt werden. Untersuchungen zeigen, dass dies eine einfache Methode ist, gute Farbwerte zu ermitteln. Aus einem gebinnten Rohbild 160 eines Bildsensors mit CMYG-Mosaikfilter wird durch Anwendung eines Filters 161, welcher eine horizontale Mittelung oder eine horizontale gewichtete Mittelung vornimmt, ein Helligkeitsbild aus Y-Werten 162 gewonnen. Aus diesem wird durch Anwendung von Hochpassfiltern (HF) verschiedener Richtungen 163 ein Hochfrequenzbild 164 mit HY-Werten gewonnen. Weiterhin wird das Rohbild 160 aufgeteilt in einen Rohbildstapel 165 der gebinnten Farbkombinationen gc, ym, cm und yg. Fehlende Positionen in dem Rohbildstapel werden ergänzt durch Mittelwertbildung 166 aus den vorhandenen Werten direkter Nachbarn unter Verwendung von Operatoren AVG, welche die Richtung der Nachbarschaft berücksichtigen, plus 167 den entsprechenden HY Wert des Hochfrequenzbildes 164. Dadurch wird ein Bildstapel 168 erhalten, in dem zu jeder Bildposition Werte von vier Farbkombinationen vorliegen. Durch Differenzbildung 169 der gc und ym-Werte bzw. der cm und yg-Werte und eine Linearkombination durch die mit Faktoren 171 u1, v1, u2 und v2 gewichtete Summation 171 wird ein Ergebnisbildstapel 172 erhalten, wobei dessen Y-Bild aus den Y-Werten 162 übernommen wird, in dem für jede Pixelposition ein Y, ein U und ein V-Wert vorliegen. Für ein erstes gebinntes Halbbild A wird ein erfindungsgemäßes Demosaicing 180 durchgeführt und das erhaltene Ergebnishalbbild 182 wird gespeichert. Für ein zweites gebinntes Halbbild B, welches gegenüber dem ersten um eine Pixelzeile verschoben ist, wird ebenfalls ein erfindungsgemäßes Demosaicing 181 durchgeführt und falls erforderlich das erhaltene Ergebnishalbbild gespeichert 183. Aus beiden Bildern 182 und 183, von denen wenigstens eines gespeichert ist, wird durch das Bildverarbeitungsmittel abwechselnd jeweils eine Zeile ausgegeben, so dass ein fortlaufendes Ergebnisfarbbild 185 erhalten wird. Dadurch wird eine Datenausgabe aus dem Bildverarbeitungsgerät (z. B. Kamera) bewirkt, die auf vorteilhafter Weise der für digitale Bildverarbeitungsgeräte üblichen Ausgabe als ”Progressive Scan”-Vollbild entspricht. Alternativ zu Dadurch wird eine Datenausgabe aus dem Bildverarbeitungsgerät (z. B. Kamera) bewirkt, die auf vorteilhafter Weise der für digitale Bildverarbeitungsgeräte üblichen Ausgabe als ”Progressive Scan”-Vollbild entspricht. Es ist zu beachten, dass das fortlaufende, gebinnte Vollbild ein von den obengenannten Mustern abweichendes Farbmuster besitzt. Zur Interpolation und zur Hochpassfilterung eignet sich bspw. das Verfahren des nächsten Nachbarn (”nearest neighbour”) sowie eine Ausweitung der oben genannten Verfahren auf den übernächsten Nachbarn an. Die Auswertung erfolgt hierbei aus praktischen Gründen durch eine Rechenvorschrift mit einer gewichteten Mittelung, wobei das Gewicht jeweils umgekehrt zum Abstand zum entsprechenden Nachbarn gewählt wird. Des Weiteren kann auch die Hochpassfilterung auf übernächste Nachbarn ausgeweitet und eine geeignete Rechenvorschrift anwendet werden. Die oben genannten Bilder müssen nicht alle explizit ermittelt und gespeichert werden. Sie dienen zur Veranschaulichung des Verfahrens. So können z. B. jeweils mehrere Schritte zusammengefasst werden. Auch kann ggf. auf die Berechnung nicht weiter verwendeter Zwischenergebnisse verzichtet werden. Das beschriebene Bildverarbeitungsverfahren und -gerät kann in einer Kamera beispielsweise in einem Prozessor (z. B. DSP) oder einem FPGA implementiert werden. Es ist möglich, aus YUV-Daten mit bekannten Verfahren Farbvektoren eines anderen Farbraumes z. B. des RGB- oder des sRGB- oder aus des L*a*b*-Farbraumes zu errechnen. Weiterhin können solche Berechnungen mit den vorstehend beschriebenen Rechenvorschriften der Ausführungsbeispiele zur Berechnung für die Y-, U- und V-Werte zusammengeführt, um dadurch ohne Ermittlung eines YUV-Wertes direkt einen Farbvektor eines anderen Farbraumes zu bestimmen. Es ist möglich, alle ermittelten Werte aus dem Bildverarbeitungsgerät auszugeben. Auch ist es möglich, Protokolle zu verwenden, z. B. YUV 4:2:2, bei denen nur Teile der ermittelten Information ausgegeben werden. Auch ist es möglich, auf die Berechnung solcher Informationen, die nicht ausgegeben werden, zu verzichten. Diese Liste der vom Anmelder aufgeführten Dokumente wurde automatisiert erzeugt und ist ausschließlich zur besseren Information des Lesers aufgenommen. Die Liste ist nicht Bestandteil der deutschen Patent- bzw. Gebrauchsmusteranmeldung. Das DPMA übernimmt keinerlei Haftung für etwaige Fehler oder Auslassungen. Die Erfindung betrifft ein Verfahren und eine Vorrichtung zur Bildverarbeitung, wobei Rohdaten eines CYMG-Bildsensors mittels eines Mosaikfilters durch Demosaicing in ein Farbbild umgewandelt werden, bei dem für jeden Bildpunkt ein Farbvektor in einem Farbraum vorliegt. Bildverarbeitungsgerät mit: Bildverarbeitungsgerät nach Anspruch 1, wobei der Bildsensor mit dem CMYG-Mosaikfilter für eine halbbildweise Bildausgabe eingerichtet und im Binning betrieben wird. Bildverarbeitungsgerät nach Anspruch 1 oder 2, wobei das Bildverarbeitungsmittel ausgestaltet ist, um mittels Demosaicing bei halbbildweiser Bildausgabe und Binning für mindestens jedes Halbbild ein Helligkeitsbild zu ermittelt, und wobei jeder Bildposition ein Helligkeitswert (Y) zugeordnet ist. Bildverarbeitungsgerät nach Anspruch 3, wobei das Bildverarbeitungsmittel ausgestaltet ist, um für das Demosaicing für jede Pixelposition ein Wert jedes gebinnten Farbwertes zu ermitteln. Bildverarbeitungsgerät nach Anspruch 3 oder 4, wobei das Bildverarbeitungsmittel ausgestaltet ist, um bei der Ermittlung fehlender Werte gebinnter Farben den fehlenden Wert aus den bekannten Werten nächster Nachbarn rechnerisch zu ermitteln. Bildverarbeitungsgerät nach Anspruch 5, wobei das Bildverarbeitungsmittel ausgestaltet ist, um die fehlenden Werte gebinnter Farben durch Interpolation oder Mittelwertbildung zu berechnen. Bildverarbeitungsgerät nach Anspruch 5, wobei das Bildverarbeitungsmittel ausgestaltet ist, um die fehlenden Werte basierend auf einem hochfrequenten Anteil im Helligkeitsverlauf des Helligkeitsbilds zu ermitteln. Bildverarbeitungsgerät nach Anspruch 7, wobei das Bildverarbeitungsmittel ausgestaltet ist, um den hochfrequenten Anteil mittels Subtraktion des Mittelwerts bekannter Helligkeitswerte nächster Nachbarn vom Helligkeitswert des fraglichen Pixels zu ermitteln. Bildverarbeitungsgerät nach Anspruch 7 oder 8, wobei das Bildverarbeitungsmittel ausgestaltet ist, um den hochfrequente Anteil unter Berücksichtigung der erforderlichen Raumrichtung zu ermitteln. Bildverarbeitungsgerät nach Anspruch 7, wobei das Bildverarbeitungsmittel ausgestaltet ist, um einen fehlenden gebinnten Farbwert durch Addition eines aus benachbarten Farbwerten ermittelten Werts mit einem hochfrequenten Helligkeitswert zu ermitteln. Bildverarbeitungsgerät nach Anspruch 5, wobei das Bildverarbeitungsmittel ausgestaltet ist, um aus vier gebinnten Farbwerten eines Pixels zwei Farbwerte U und V zu ermitteln. Bildverarbeitungsgerät nach Anspruch 11, wobei das Bildverarbeitungsmittel ausgestaltet ist, um auf die vier gebinnten Farbwerte einen Weißabgleich dergestalt anzuwenden, dass die Farbwerte jeweils mit einem Korrekturwert multipliziert werden. Bildverarbeitungsgerät nach Anspruch 12, wobei das Bildverarbeitungsmittel ausgestaltet ist, dass Differenzen der weißabgeglichenen gebinnten Farbwerte (cg und ym, bzw. cm und yg) ermittelt und aus den erhaltenen Differenzen durch Linearkombination die Farbwerte U und V ermittelt werden. Bildverarbeitungsgerät nach einem der vorhergehenden Ansprüche, wobei das Bildverarbeitungsmittel ausgestaltet ist, um für ein erstes gebinntes Halbbild ein Demosaicing durchzuführen und das erhaltene Ergebnishalbbild zu speichern, für ein zweites gebinntes Halbbild, welches gegenüber dem ersten um eine Pixelzeile verschoben ist, ebenfalls ein Demosaicing durchzuführen, und aus dem ersten und zweiten gebinnten Halbbild abwechselnd jeweils eine Zeile über die Schnittstelle auszugeben, so dass ein fortlaufendes Ergebnisfarbbild erhalten wird. Bildverarbeitungsgerät nach einem der Ansprüche 1 bis 13, wobei das Bildverarbeitungsmittel ausgestaltet ist, um ein gebinntes erstes Halbbild als Rohbild zwischen zu speichern und aus dem gebinnten ersten Halbbild und einem gebinnten zweiten Halbbild ein fortlaufendes Vollbild zu erzeugen, auf welches ein Demosaicing angewendet wird. Bildverarbeitungsverfahren mit den Schritten: ZITATE ENTHALTEN IN DER BESCHREIBUNG

Zitierte Patentliteratur

Zitierte Nicht-Patentliteratur

– einem Bildverarbeitungsmittel;

– einem Bildsensor mit einem Mosaikfilter bestehend aus Farbfiltern der Farben Cyan (C), Magenta (M), Gelb (Y) und Grün (G); und

– einer digitalen Schnittstelle zur Ausgabe von Bilddaten, bei denen jeder Bildpunkt mindestens zwei Werte zur Beschreibung seiner Farbe aufweist,

– dadurch gekennzeichnet, dass

– das Bildverarbeitungsmittel ausgestaltet ist, fehlenden Werte zur Beschreibung der Farbe von Bildpunkten rechnerisch zu ermitteln

– Erfassen von pixelorientierten Bilddaten mit einem Bildsensor mit einem Mosaikfilter bestehend aus Farbfiltern der Farben Cyan (C), Magenta (M), Gelb (Y) und Grün (G); und

– Ausgabe von Bilddaten, bei denen jeder Bildpunkt mindestens zwei Werte zur Beschreibung seiner Farbe aufweist,

– gekennzeichnet durch

– rechnerische Ermittlung fehlender Werte zur Beschreibung der Farbe von Bildpunkten.