ELECTRONIC CONTROL DEVICE AND VEHICLE INCLUDING SAME

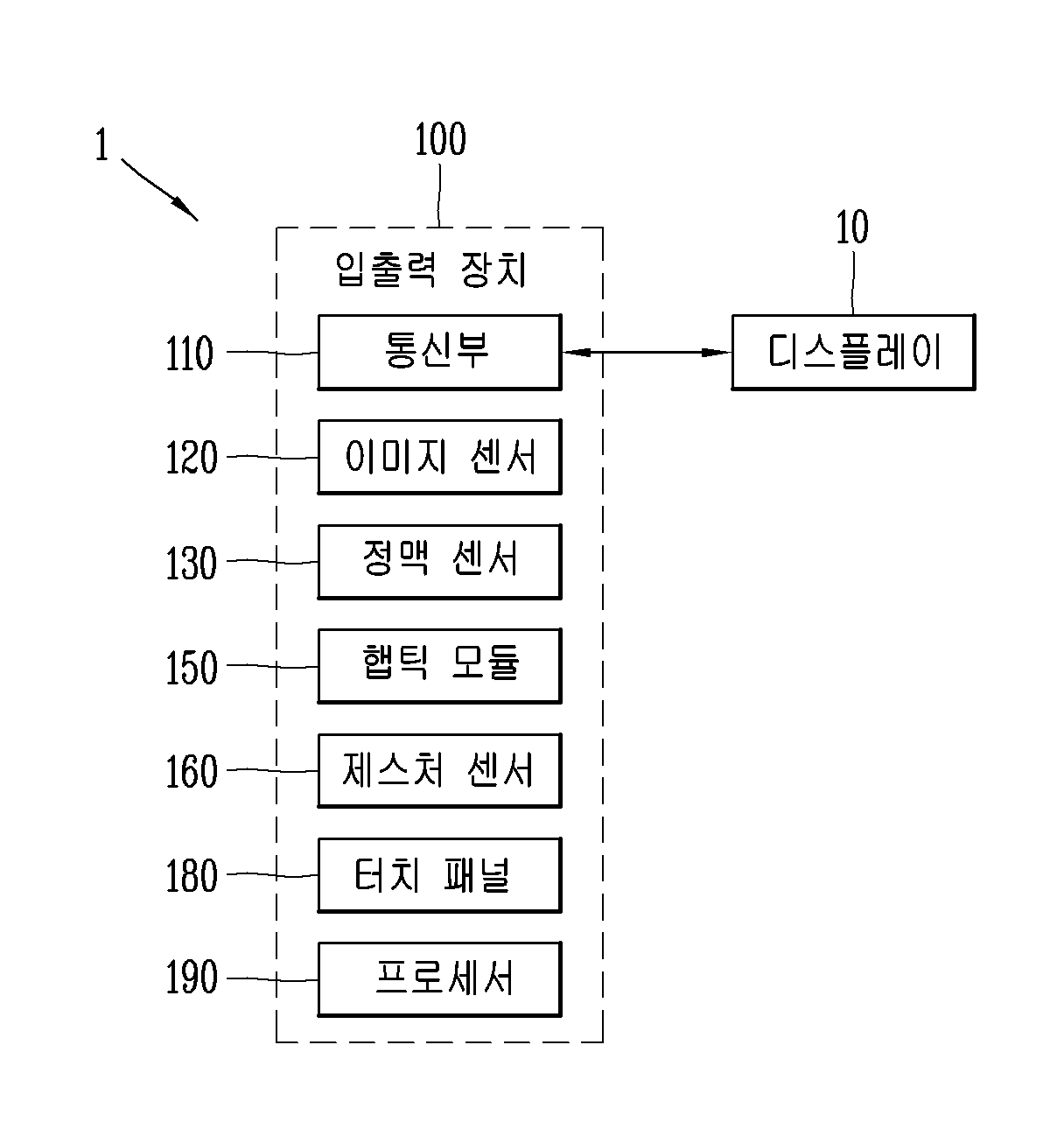

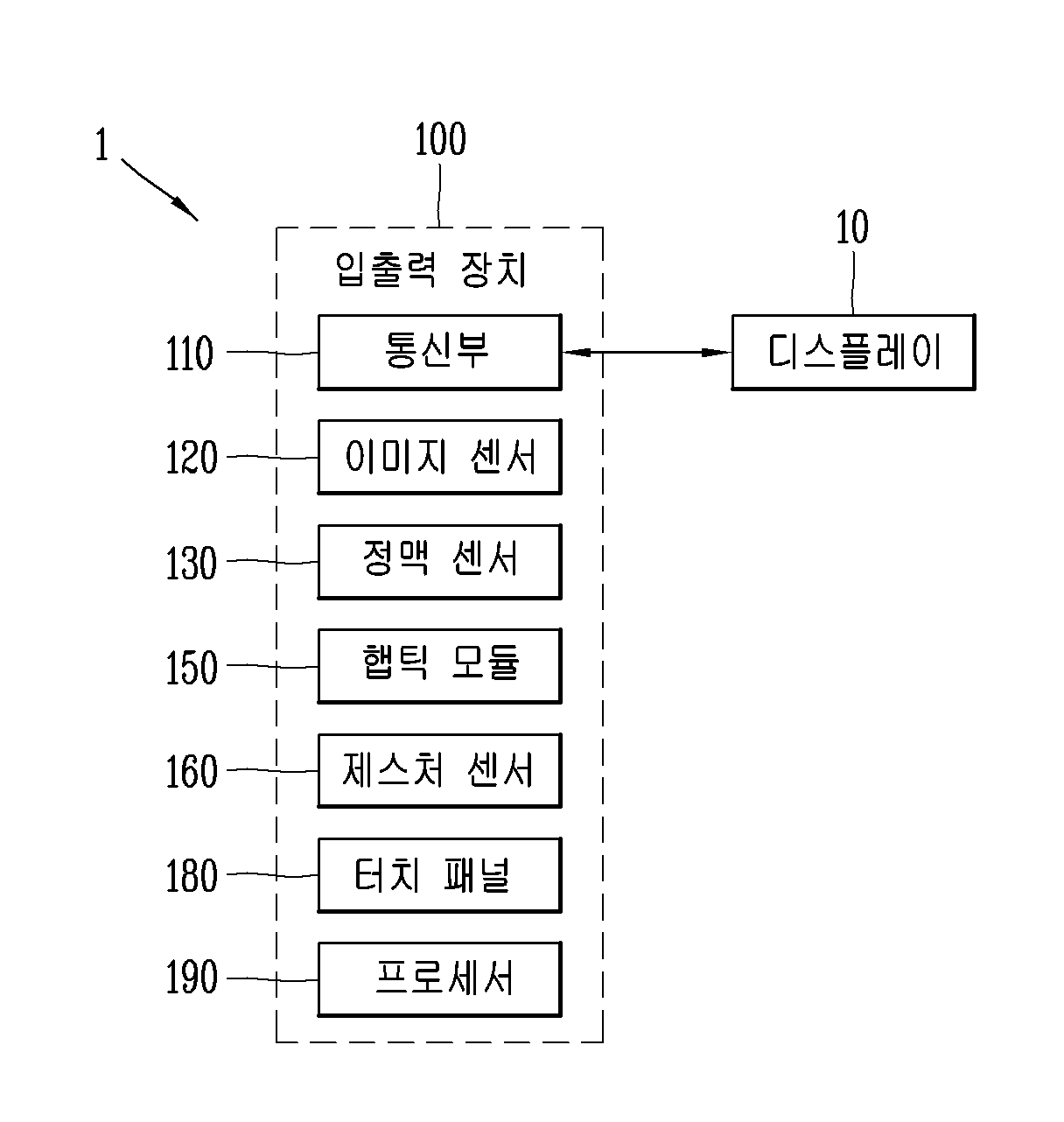

본 발명은 전자 제어 장치 및 그것을 포함하는 차량에 관한 것이다. 차량은 운동 에너지를 이용하여 사람이나 짐을 이동시킬 수 있는 교통 수단을 의미한다. 차량의 대표적인 예로, 자동차 및 오토바이를 들 수 있다. 차량을 이용하는 사용자의 안전 및 편의를 위해, 차량에는 각종 센서와 장치가 구비되고 있으며, 차량의 기능이 다양화 되고 있다. 차량의 기능은 운전자의 편의를 도모하기 위한 편의 기능, 그리고 운전자 및/또는 보행자의 안전을 도모하기 위한 안전 기능으로 나뉠 수 있다. 먼저, 편의 기능은 차량에 인포테인먼트(information + entertainment) 기능을 부여하고, 부분적인 자율 주행 기능을 지원하거나, 야간 시야나 사각 지대와 같은 운전자의 시야 확보를 돕는 등의 운전자 편의와 관련된 개발 동기를 가진다. 예를 들어, 적응 순향 제어(active cruise control, ACC), 스마트주자시스템(smart parking assist system, SPAS), 나이트비전(night vision, NV), 헤드 업 디스플레이(head up display, HUD), 어라운드 뷰 모니터(around view monitor, AVM), 적응형 상향등 제어(adaptive headlight system, AHS) 기능 등이 있다. 안전 기능은 운전자의 안전 및/또는 보행자의 안전을 확보하는 기술로, 차선 이탈 경고 시스템(lane departure warning system, LDWS), 차선 유지 보조 시스템(lane keeping assist system, LKAS), 자동 긴급 제동(autonomous emergency braking, AEB) 기능 등이 있다. 상술한 편의 기능과 안전 기능이 보다 더 향상될 수 있도록, 차량에 특화된 통신 기술이 개발되고 있다. 예를 들어, 차량과 인프라간의 통신을 가능케 하는 V2I(Vehicle to Infrastructure), 차량과 차량간의 통신을 가능케 하는 V2V(Vehicle to Vehicle) 그리고, 차량과 사물간의 통신을 가능케 하는 V2X(Vehicle to Everything) 등이 있다. 차량의 기능은 다양해지고 있으나, 사용자로부터 입력을 받거나 사용자에게 각종 정보를 출력하는 전자 제어 장치는 터치스크린에 한정되어 있다. 터치스크린만으로는 탑승객이 원하는 기능이 빠르게 선택될 수 없으므로, 즉각적으로 기능을 실행할 수 있도록 형성된 각종 사용자 입력장치가 차량에 구비된다. 예를 들어, 상기 사용자 입력장치는, 버튼 방식, 레버 방식, 조그 휠(jog wheel) 방식의 입력장치 등을 포함할 수 있다. 차량의 기능이 다양해질수록 차량에는 다수의 사용자 입력장치들이 구비될 수 밖에 없다. 예를 들어, 히트 시트(heat seat)가 개발됨에 따라, 히트 시트의 온/오프에 연계된 히트 시트 버튼이 차량에 추가적으로 구비되고 있다. 히트 시트는 주로 겨울에만 사용하는 기능임에도, 상기 히트 시트 버튼은 항상 상기 차량의 일 지점에서 소정 공간을 차지해야만 하는 문제가 있다. 차량 내부의 공간을 효율적으로 구성하면서도, 탑승객이 필요한 기능을 빠르게 선택할 수 있도록 하는 새로운 방식의 사용자 인터페이스에 대한 사용자 요구가 증가하고 있다. 본 발명은 전술한 문제 및 다른 문제를 해결하는 것을 목적으로 한다. 본 발명의 일 목적은, 비접촉식 사용자 입력을 감지하고, 비접촉식 피드백을 제공할 수 있는 새로운 방식의 전자 제어 장치를 제공하는 것이다. 본 발명의 일 목적은, 공간을 효율적으로 사용하면서도, 탑승객이 쉽고 빠르게 특정 기능을 선택할 수 있도록 하는 전자 제어 장치를 제공하는 것이다. 본 발명의 일 목적은, 탑승객의 제스처에 근거하여 특정 기능을 빠르게 실행할 수 있는 전자 제어 장치를 제공하는 것이다. 본 발명은 전자 제어 장치 그리고 상기 전자 제어장치 장치가 구비된 차량을 제공한다. 상기 전자 제어 장치는, 차량에 탑승한 탑승객의 시선을 추적하는 이미지 센서; 상기 탑승객의 손 및 손가락 중 적어도 하나의 움직임에 의하여 정의되는 제스처를 추적하는 제스처 센서; 및 상기 시선이 향하는 오브젝트를 탐색하고, 상기 제스처가 기준 조건을 만족하는 것에 응답하여 상기 오브젝트에 연관된 기능들 중 상기 제스처에 대응하는 어느 하나의 기능을 실행하는 프로세서를 포함한다. 일 실시 예에 따르면, 상기 프로세서는, 소정 공간에 상기 오브젝트에 연관된 기능들에 대응하는 복수의 구역들을 설정하고, 상기 제스처가 상기 복수의 구역들 중 어느 하나의 구역에서 수신되는 것에 응답하여 상기 어느 하나의 구역에 대응하는 상기 어느 하나의 기능을 실행할 수 있다. 일 실시 예에 따르면, 상기 복수의 구역들은 3차원 행렬을 형성할 수 있다. 일 실시 예에 따르면, 상기 전자 제어 장치는, 공기의 진동을 이용하여 촉각 효과를 발생시키는 햅틱 모듈을 더 포함하고, 상기 프로세서는, 상기 탑승객의 손이 상기 어느 하나의 구역의 가장자리에 위치하면 제1크기의 진동이 발생하고, 상기 어느 하나의 구역의 중앙에 위치하면 상기 제1크기보다 큰 제2크기의 진동이 발생하도록 상기 햅틱 모듈을 제어할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 탑승객이 제1 탑승객인 경우 각 구역의 크기를 제1크기로 설정하고, 상기 탑승객이 제2 탑승객인 경우, 각 구역의 크기를 상기 제1크기와 다른 제2크기로 설정할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 오브젝트에 근거하여 상기 소정 공간에 자연수인 n개의 구역들을 설정하며, 상기 n은 상기 시선이 향하는 상기 오브젝트에 따라 달라질 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 n개의 구역들을 가이드 하는 영상이 상기 차량에 구비된 디스플레이에 표시되도록 상기 통신부를 제어할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 n개의 구역들 중 제1구역에 상기 탑승객의 손이 위치하는 경우, 상기 영상에서 상기 제1구역에 하이라이트가 이루어지도록 상기 통신부를 제어할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 영상이 표시된 상태에서 기설정된 제스처가 감지되는 경우, 상기 n개의 구역들을 회전 이동시켜 각 구역의 위치를 재설정할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 오브젝트에 연관된 기능들 각각에 설정되어 있는 설정 값에 따라 각 구역의 크기를 조정할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 오브젝트에 연관된 기능들의 각각이 실행된 횟수에 근거하여 상기 설정 값을 업데이트할 수 있다. 일 실시 예에 따르면, 상기 소정 공간은 상기 탑승객을 기준으로 정의되며, 상기 소정 공간의 크기 및 위치 중 적어도 하나는 상기 탑승객에 따라 달라질 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 기설정된 트리거 제스처가 감지되는 것에 응답하여 상기 소정 공간에 상기 복수의 구역들을 설정하며, 상기 트리거 제스처가 감지된 위치에 근거하여 상기 소정 공간의 중심점을 설정할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 제1 및 제2 탑승객이 상기 차량에 탑승한 경우, 상기 제1 탑승객을 위한 제1 소정 공간에 제1그룹에 포함된 구역들을 설정하고, 상기 제2 탑승객을 위한 제2 소정 공간에 제2그룹에 포함된 구역들을 설정할 수 있다. 일 실시 예에 따르면, 상기 프로세서는 상기 제1 소정 공간과 상기 제2 소정 공간이 겹쳐지지 않도록 상기 제1 및 제2 소정 공간을 설정할 수 있다. 일 실시 예에 따르면, 상기 전자 제어 장치는, 공기의 진동을 이용하여 촉각 효과를 발생시키는 햅틱 모듈을 더 포함하고, 상기 프로세서는, 상기 제1 탑승객의 손이 상기 제2 소정 공간으로 진입하는 경우, 상기 제1 탑승객의 손에 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 제1 탑승객의 손과 상기 제2 소정 공간의 중심점 사이의 거리에 따라 서로 다른 방식의 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 탑승객을 기준으로 가상의 기준점을 설정하고, 상기 기준점 그리고 상기 손의 움직임이 감지된 영역의 일 지점 사이의 거리에 근거하여 상기 어느 하나의 기능에 이용되는 변수를 가변적으로 결정할 수 있다. 일 실시 예에 따르면, 상기 전자 제어 장치는, 공기의 진동을 이용하여 촉각 효과를 발생시키는 햅틱 모듈을 더 포함하고, 상기 프로세서는, 상기 변수에 대응하는 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 시선이 상기 차량에 구비된 디스플레이를 향하는 경우, 상기 시선에 근거하여 상기 디스플레이에 포함된 복수의 그래픽 객체들 중 어느 하나를 상기 오브젝트로 탐색할 수 있다. 일 실시 예에 따르면, 상기 프로세서는, 상기 오브젝트가 탐색되는 경우, 상기 오브젝트와 관련된 상세정보가 상기 차량에 구비된 디스플레이에 표시되도록 상기 통신부를 제어할 수 있다. 본 발명에 따른 전자 제어 장치 및 그것을 포함하는 차량의 효과에 대해 설명하면 다음과 같다. 본 발명에 따르면 차량의 탑승객은 시선을 통해 오브젝트를 특정하고, 허공에서 움직이는 제스처에 근거하여 상기 오브젝트와 관련된 다양한 기능들을 실행할 수 있다. 이를 통해 탑승객은 앉은 자리에서 손에 닿지 않는 장치에 대하여 특정 기능을 실행시킬 수 있으며, 다양한 제스처를 이용해 다양한 기능을 빠르게 실행시킬 수 있다. 본 발명에 따르면 정맥 인증을 이용하여 탑승객에게 서로 다른 사용자 인터페이스를 제공할 수 있으며, 정맥 인증이 원활히 이루어지도록 정맥 인증 가능 영역을 가이드 하는 촉각 효과를 발생시키기 때문에 사용자는 정확한 위치로 손을 이동시킬 수 있다 도 1은 본 발명의 일 실시 예에 따른 전자 제어 장치를 설명하기 위한 블록도 도 2a 및 도 2b는 도 1에서 설명한 일부 구성 요소의 배치를 설명하기 위한 예시도 도 3은 도 1의 전자 제어 장치에 의한 제어방법을 설명하기 위한 흐름도 도 4a 및 도 4b는 도 3의 제어방법을 설명하기 위한 예시도들 도 5는 복수의 기능들 중 어느 하나의 기능을 탑승객으로부터 선택받기 위한 가상의 구역들을 제공하는 제어방법을 설명하기 위한 흐름도 도 6은 탑승객의 시선이 디스플레이를 향하는 경우의 제어방법을 설명하기 위한 흐름도 도 7a 및 도 7b는 도 6의 제어방법을 설명하기 위한 예시도들 도 8은 도 5에서 설명한 가상의 구역들을 가변시키는 제어방법을 설명하기 위한 흐름도 도 9a, 9b, 9c 및 9d는 도 8의 제어방법을 설명하기 위한 예시도들 도 10a 및 도 10b는 트리거 제스처에 따라 가상의 구역들이 형성되는 위치가 달라지는 예를 설명하기 위한 예시도들 도 11은 가상의 구역들에 대한 촉각 효과를 제공하는 제어방법을 설명하기 위한 흐름도 도 12a 및 도 12b는 도 11의 제어방법을 설명하기 위한 예시도들 도 13은 복수의 탑승객들이 탑승한 경우 전자 제어 장치의 동작을 설명하기 위한 개념도 도 14는 복수의 탑승객들이 탑승한 경우의 제어방법을 설명하기 위한 흐름도 이하, 첨부된 도면을 참조하여 본 명세서에 개시된 실시 예를 상세히 설명하되, 도면 부호에 관계없이 동일하거나 유사한 구성요소는 동일한 참조 번호를 부여하고 이에 대한 중복되는 설명은 생략하기로 한다. 이하의 설명에서 사용되는 구성요소에 대한 접미사 "모듈" 및 "부"는 명세서 작성의 용이함만이 고려되어 부여되거나 혼용되는 것으로서, 그 자체로 서로 구별되는 의미 또는 역할을 갖는 것은 아니다. 또한, 본 명세서에 개시된 실시 예를 설명함에 있어서 관련된 공지 기술에 대한 구체적인 설명이 본 명세서에 개시된 실시 예의 요지를 흐릴 수 있다고 판단되는 경우 그 상세한 설명을 생략한다. 또한, 첨부된 도면은 본 명세서에 개시된 실시 예를 쉽게 이해할 수 있도록 하기 위한 것일 뿐, 첨부된 도면에 의해 본 명세서에 개시된 기술적 사상이 제한되지 않으며, 본 발명의 사상 및 기술 범위에 포함되는 모든 변경, 균등물 내지 대체물을 포함하는 것으로 이해되어야 한다. 제1, 제2 등과 같이 서수를 포함하는 용어는 다양한 구성요소들을 설명하는데 사용될 수 있지만, 상기 구성요소들은 상기 용어들에 의해 한정되지는 않는다. 상기 용어들은 하나의 구성요소를 다른 구성요소로부터 구별하는 목적으로만 사용된다. 어떤 구성요소가 다른 구성요소에 "연결되어" 있다거나 "접속되어" 있다고 언급된 때에는, 그 다른 구성요소에 직접적으로 연결되어 있거나 또는 접속되어 있을 수도 있지만, 중간에 다른 구성요소가 존재할 수도 있다고 이해되어야 할 것이다. 반면에, 어떤 구성요소가 다른 구성요소에 "직접 연결되어" 있다거나 "직접 접속되어" 있다고 언급된 때에는, 중간에 다른 구성요소가 존재하지 않는 것으로 이해되어야 할 것이다. 단수의 표현은 문맥상 명백하게 다르게 뜻하지 않는 한, 복수의 표현을 포함한다. 본 출원에서, "포함한다" 또는 "가지다" 등의 용어는 명세서상에 기재된 특징, 숫자, 단계, 동작, 구성요소, 부품 또는 이들을 조합한 것이 존재함을 지정하려는 것이지, 하나 또는 그 이상의 다른 특징들이나 숫자, 단계, 동작, 구성요소, 부품 또는 이들을 조합한 것들의 존재 또는 부가 가능성을 미리 배제하지 않는 것으로 이해되어야 한다. 도 1은 본 발명의 일 실시 예에 따른 전자 제어 장치를 설명하기 위한 블록도이다. 본 발명은 차량에 탑승한 탑승객으로부터 입력을 수신하고, 차량과 관련된 각종 정보를 탑승객에게 출력할 수 있는 새로운 방식의 전자 제어 장치 및 상기 전자 제어 장치를 구비한 차량을 제공한다. 도 1은 본 발명의 일 실시 예에 따른 전자 제어 장치를 설명하기 위한 블록도이다. 전자 제어 장치(100)는 차량(1)에 구비되는 것으로, 차량(1)에 탈부착이 가능한 독립된 장치로 이루어지거나, 차량(1)에 일체형으로 설치되어 차량(1)의 일부 구성 요소일 수 있다. 이하에서는, 설명의 편의를 위해 상기 전자 제어 장치(100)를 상기 차량(1)과 독립된 별도의 구성인 것으로 설명한다. 다만, 이는 본 발명의 일 실시 예에 불과하며, 본 명세서에서 설명하는 모든 전자 제어 장치(100)의 동작 및 제어방법은, 상기 차량(1)에 구비된 적어도 하나의 전자 제어 장치(Electronic Control Unit)에 의해 수행될 수 있다. 도 1을 참조하면, 상기 전자 제어 장치(100)는 통신부(110), 이미지 센서(130), 햅틱 모듈(150), 제스처 센서(160), 터치 패널(170) 및 프로세서(190) 중 적어도 하나를 포함한다. 통신부(110)는 차량(1)에 구비된 다양한 구성요소들과 통신을 수행하도록 이루어진다. 일 예로, 통신부(110)는 CAN(controller are network)을 통해 제공되는 각종 정보를 수신할 수 있다. 다른 일 예로, 통신부(110)는, 차량, 이동 단말기와 서버, 다른 차량과 같이 통신 가능한 모든 기기와 통신을 수행할 수 있다. 이는, V2X(Vehicle to everything) 통신으로 명명될 수 있다. V2X 통신은 운전 중 도로 인프라 및 다른 차량과 통신하면서 교통상황 등의 정보를 교환하거나 공유하는 기술로 정의될 수 있다. 통신부(110)는 상기 차량(1)에 구비된 하나 또는 그 이상의 디스플레이들(10)과 통신을 수행하도록 이루어진다. 나아가, 통신부(110)는 차량(1)에 구비된 대부분의 장치들로부터 차량의 주행과 관련된 정보를 수신할 수 있다. 상기 차량(1)에서 상기 전자 제어 장치(100)로 전송되는 정보를 ‘차량 주행 정보’로 호칭한다. 차량 주행 정보는 차량 정보 및 차량의 주변 정보를 포함한다. 차량(1)의 프레임을 기준으로 차량 내부와 관련된 정보를 차량 정보, 차량 외부와 관련된 정보를 주변 정보로 정의할 수 있다. 차량 정보는 차량 자체에 관한 정보를 의미한다. 예를 들어, 차량 정보는 차량의 주행속도, 주행방향, 가속도, 각속도, 위치(GPS), 무게, 차량의 탑승인원, 차량의 제동력, 차량의 최대 제동력, 각 바퀴의 공기압, 차량에 가해지는 원심력, 차량의 주행모드(자율주행모드인지 수동주행인지 여부), 차량의 주차모드(자율주차모드, 자동주차모드, 수동주차모드), 차량 내에 사용자가 탑승해있는지 여부 및 상기 사용자와 관련된 정보 등을 포함할 수 있다. 주변 정보는 차량을 중심으로 소정 범위 내에 위치하는 다른 물체에 관한 정보 및 차량 외부와 관련된 정보를 의미한다. 예를 들어, 차량이 주행중인 노면의 상태(마찰력), 날씨, 전방(또는 후방) 차량과의 거리, 전방(또는 후방) 차량의 상대속도, 주행중인 차선이 커브인 경우 커브의 굴곡률, 차량 주변밝기, 차량을 기준으로 기준영역(일정영역) 내에 존재하는 객체와 관련된 정보, 상기 일정영역으로 객체가 진입/이탈하는지 여부, 차량 주변에 사용자가 존재하는지 여부 및 상기 사용자와 관련된 정보(예를 들어, 상기 사용자가 인증된 사용자인지 여부) 등일 수 있다. 또한, 상기 주변 정보는, 주변밝기, 온도, 태양위치, 주변에 위치하는 객체 정보(사람, 타차량, 표지판 등), 주행중인 노면의 종류, 지형지물, 차선(Line) 정보, 주행 차로(Lane) 정보, 자율주행/자율주차/자동주차/수동주차 모드에 필요한 정보를 포함할 수 있다. 또한, 주변 정보는, 차량 주변에 존재하는 객체(오브젝트)와 차량(1)까지의 거리, 충돌 가능성, 상기 객체의 종류, 차량이 주차 가능한 주차공간, 주차공간을 식별하기 위한 객체(예를 들어, 주차선, 노끈, 타차량, 벽 등) 등을 더 포함할 수 있다. 상기 차량 주행 정보는 이상에서 설명한 예에 한정되지 않으며, 상기 차량(1)에 구비된 구성요소로부터 생성된 모든 정보를 포함할 수 있다. 상기 프로세서(190)는 상기 통신부(110)를 이용하여 상기 차량(1)에 구비된 하나 또는 그 이상의 디스플레이들(10)을 제어할 수 있다. 구체적으로, 상기 프로세서(830)는 상기 통신부(110)를 통해 수신되는 차량 주행 정보에 근거하여, 기 설정되어 있는 복수의 조건들 중에서 적어도 하나의 조건이 만족되는지를 판단할 수 있다. 만족되는 조건에 따라, 상기 프로세서(830)는 상기 하나 또는 그 이상의 디스플레이들을 서로 다른 방식으로 제어할 수 있다. 기 설정된 조건과 관련하여, 상기 프로세서(830)는 차량(1)에 구비된 전장품 및/또는 애플리케이션에서 이벤트가 발생한 것을 감지하고, 감지된 이벤트가 기 설정된 조건을 만족하는지를 판단할 수 있다. 이때, 상기 프로세서(830)는 통신부(110)를 통해 수신된 정보로부터 이벤트가 발생한 것을 감지할 수도 있다. 상기 애플리케이션은 위젯(widget)이나 홈 런처 등을 포함한 개념으로서, 차량(1)에서 구동 가능한 모든 형태의 프로그램을 의미한다. 따라서, 상기 애플리케이션은 웹 브라우저, 동영상 재생, 메세지 송수신, 일정 관리, 애플리케이션의 업데이트의 기능을 수행하는 프로그램이 될 수 있다. 나아가, 상기 애플리케이션은 전방 추돌 방지(Forward Collision Warning, FCW), 사각 지대 감지(Blind Spot Detection, BSD), 차선 이탈 경고(Lane Departure Warning, LDW), 보행자 감지(Pedestrian Detection, PD), 커브 속도 경고(Curve Speed Warning, CSW) 및 턴 바이 턴 길안내(turn by turn navigation, TBT) 중 적어도 하나를 포함할 수 있다. 예를 들어, 이벤트 발생은, 부재중 전화가 있는 경우, 업데이트 대상인 애플리케이션이 있는 경우, 메세지가 도착한 경우, 시동 온(start on), 시동 오프(start off), 자율 주행 온/오프, 디스플레이 활성화 키 눌림(LCD awake key), 알람(alarm), 호 연결(Incoming call), 부재중 알림(missed notification) 등이 될 수 있다. 다른 예로서, 이벤트 발생은 ADAS(advanced driver assistance system)에서 설정한 경고 발생, ADAS에서 설정한 기능이 수행되는 경우일 수 있다. 예를 들어, 전방 충돌 경고(forward collision warning)가 발생하는 경우, 후측방 경고(blind spot detection)가 발생하는 경우, 차선 이탈 경보(lane departure warning)가 발생하는 경우, 주행 조향 보조 경보(lane keeping assist warning)가 발생하는 경우, 긴급 제동 기능(autonomous emergency braking)이 수행되는 경우에 이벤트가 발생한 것으로 볼 수 있다. 또 다른 예로서, 전진 기어에서 후진 기어로 변경되는 경우, 소정 값보다 큰 가속이 발생되는 경우, 소정 값보다 큰 감속이 발생되는 경우, 동력장치가 내연기관에서 모터로 변경되는 경우, 또는 모터에서 내연기관으로 변경되는 경우에도 이벤트가 발생한 것으로 볼 수 있다. 이 밖에도, 차량(1)에 구비된 다양한 ECU가 특정 기능을 수행하는 경우에도 이벤트가 발생한 것으로 볼 수 있다. 발생한 이벤트가 기 설정된 조건에 만족되는 경우, 상기 프로세서(190)는 만족되는 조건에 대응하는 정보가 상기 하나 또는 그 이상의 디스플레이들(1)에 표시되도록 상기 통신부(110)를 제어한다. 이미지 센서(120)는 상기 차량(1)에 탑승한 탑승객의 시선을 추적하도록 이루어진다. 시선을 추적하기 위한 다양한 기술이 이미지 센서(120)를 통해 구현될 수 있으나, 본 발명에서는 시선 추적의 일 예로 실시간 촬영된 이미지의 이미지 분석을 통해 시선 추적(eye tracking)을 수행하는 방법을 설명한다. 상기 이미지 센서(120)는, 상기 탑승객의 눈을 촬영해 눈 영상을 생성하고, 상기 눈 영상을 이용하여 상기 탑승객의 시선을 추적할 수 있다. 상기 정맥 센서(130)는 상기 차량(1)에 탑승한 탑승객의 손에 대응하는 손 영상을 생성하도록 이루어진다. 구체적으로, 소정 영역에 위치한 탑승객의 손을 감지하고, 손을 촬영한 손 영상을 획득할 수 있다. 상기 정맥 센서(130)에 의해 획득된 손 영상에 의하여, 생체 인식이 이루어질 수 있고, 탑승객의 제스처가 추출되어 사용자 입력으로 활용될 수 있으며, 손의 위치가 좌표 값으로 산출될 수 있다. 일 예로, 상기 정맥 센서(130)에는 생체 인식 기술이 적용될 수 있다. 여기서, 생체 인식 기술은 생체 정보를 이용하여 개인의 신원을 확인하거나 식별하는 기술을 의미한다. 상기 정맥 센서(130)는 지문, 얼굴, 홍채, 정맥 등의 생체 정보를 획득하고, 획득한 생체 정보를 바탕으로 생체 인식 기술을 구현할 수 있다. 예를 들어, 상기 정맥 센서(130)는 손 영상을 획득하고, 상기 손 영상으로부터 정맥 패턴을 추출한 후 상기 정맥 패턴을 이용하여 개인을 식별할 수 있다. 정맥 인식 기술은 적외선을 통해 취득한 정맥 패턴 영상을 이용하여 개인을 식별하는 기술이다. 인간의 정맥은 피부 바로 밑에 복잡한 형태를 가지고 위치하며, 정맥 패턴은 개개인에 따라 다르며 나이를 먹어도 변화하지 않는 것으로 알려져 있다. 정맥은 신체 내부에 존재하므로 도난 또는 위조의 위험이 거의 없고, 피부 표면의 상태가 인식에 아무런 영향을 끼치지 않는다. 정맥 인식 기술이 적용된 정맥 센서(130)는 적외선을 이용하기 때문에 사용자의 편의성이 높은 비접촉식 장치로 이루어진다. 정맥 패턴은 안정적이고 비교적 명확하게 찾을 수 있으므로, 해상도가 낮은 카메라를 사용할 수 있다. 상기 정맥 센서(130)는 정맥 인식이 가능하도록 상기 손 영상으로부터 정맥 정보를 추출할 수 있다. 상기 정맥 정보에 의하여 탑승객 식별이 이루어질 수 있다. 상기 정맥 센서(130)는 상기 손 영상을 이용하여 손의 위치를 추적할 수 있다. 상기 정맥 센서(130)는 상기 손 영상을 이용하여 상기 손의 위치를 2차원 및/또는 3차원 좌표 값으로 산출할 수 있다. 상기 햅틱 모듈(150)은 사용자가 느낄 수 있는 다양한 촉각 효과를 발생시킨다. 햅틱 모듈(150)이 발생시키는 촉각 효과의 대표적인 예로는 진동이 될 수 있다. 햅틱 모듈(150)에서 발생하는 진동의 세기와 패턴 등은 사용자의 선택 또는 프로세서(190)의 설정에 의해 제어될 수 있다. 예를 들어, 상기 햅틱 모듈(150)은 서로 다른 진동을 합성하여 출력하거나 순차적으로 출력할 수도 있다. 상기 햅틱 모듈(150)은, 진동 외에도, 접촉 피부면에 대해 수직 운동하는 핀 배열, 분사구나 흡입구를 통한 공기의 분사력이나 흡입력, 피부 표면에 대한 스침, 전극(electrode)의 접촉, 정전기력 등의 자극에 의한 효과와, 흡열이나 발열 가능한 소자를 이용한 냉온감 재현에 의한 효과 등 다양한 촉각 효과를 발생시킬 수 있다. 상기 햅틱 모듈(150)은 직접적인 접촉을 통해 촉각 효과를 전달할 수 있을 뿐만 아니라, 사용자가 손가락이나 팔 등의 근 감각을 통해 촉각 효과를 느낄 수 있도록 상기 구현할 수도 있다. 상기 햅틱 모듈(150)은 초음파를 사용하여 공기의 진동을 발생시킴으로써 촉각 효과를 발생시킬 수 있다. 구체적으로, 피부 상에 촉각 효과를 발생시키기 위하여, 피부 내 수용체들이 느낄 수 있는 임계값인 40kHz 이상의 주파수를 갖는 초음파를 출력할 수 있다. 상기 햅틱 모듈(150)은 전자 제어 장치(100)의 구성 태양에 따라 2개 이상이 구비될 수 있다. 상기 제스처 센서(160)는 탑승객의 손 및 손가락 중 적어도 하나의 움직임에 의하여 정의되는 제스처를 추적할 수 있다. 구체적으로, 상기 제스처 센서(160)는 상기 제스처를 감지하고, 상기 제스처가 기 설정된 제스처들 중 어느 하나에 해당하는지를 판단할 수 있다. 나아가, 상기 제스처 센서(160)는 손의 위치를 2차원 및/또는 3차원의 좌표 값으로 산출할 수 있다. 상기 제스처 센서(160)의 기능은 상기 정맥 센서(130)에 의해 구현될 수도 있다. 상기 터치 패널(170)은 터치패턴을 구비하는 필름 형태로 구성될 수 있다. 상기 터치 패널(170)의 배면에 상기 정맥 센서(130)가 배치될 수 있다. 상기 터치 패널(170)은 디스플레이(미도시)와 일체로 형성될 수 있다. 예를 들어, 터치센서는, 디스플레이의 기판 상에 배치되거나, 디스플레이의 내부에 구비될 수 있다. 이처럼, 상기 터치 패널(170)은 디스플레이와 함께 터치 스크린을 형성할 수 있으며, 이 경우에 터치 스크린은 터치 입력을 수신하는 사용자 입력부로 기능할 수 있다. 도 1에 도시되어 있지 않으나, 상기 전자 제어 장치(100)는 디스플레이를 더 포함할 수도 있다. 디스플레이는, 다양한 정보에 대응되는 그래픽 객체를 표시할 수 있다. 디스플레이는 액정 디스플레이(liquid crystal display, LCD), 박막 트랜지스터 액정 디스플레이(thin film transistor-liquid crystal display, TFT LCD), 유기 발광 다이오드(organic light-emitting diode, OLED), 플렉서블 디스플레이(flexible display), 3차원 디스플레이(3D display), 전자잉크 디스플레이(e-ink display) 중에서 적어도 하나를 포함할 수 있다. 상기 디스플레이는 HUD(Head Up Display)로 구현될 수 있다. 디스플레이가 HUD로 구현되는 경우, 디스플레이는 투사 모듈을 구비하여 윈드 쉴드 또는 윈도우에 투사되는 이미지를 통해 정보를 출력할 수 있다. 상기 디스플레이는, 투명 디스플레이를 포함할 수 있다. 투명 디스플레이는 윈드 쉴드 또는 윈도우에 부착될 수 있다. 투명 디스플레이는 소정의 투명도를 가지면서, 소정의 화면을 표시할 수 있다. 투명 디스플레이는, 투명도를 가지기 위해, 투명 디스플레이는 투명 TFEL(Thin Film Elecroluminescent), 투명 OLED(Organic Light-Emitting Diode), 투명 LCD(Liquid Crystal Display), 투과형 투명디스플레이, 투명 LED(Light Emitting Diode) 디스플레이 중 적어도 하나를 포함할 수 있다. 투명 디스플레이의 투명도는 조절될 수 있다. 디스플레이는 터치 입력부와 상호 레이어 구조를 이루거나 일체형으로 형성됨으로써, 터치 스크린을 구현할 수 있다. 상기 프로세서(190)는 상기 전자 제어 장치(100)에 구비된 하나 또는 그 이상의 구성요소들을 제어하며, 상기 전자 제어 장치(100)의 전반적인 동작을 제어한다. 상기 프로세서(190)는 위에서 살펴본 구성요소들을 통해 입력 또는 출력되는 신호, 데이터, 정보 등을 처리하거나 메모리(미도시)에 저장된 응용 프로그램을 구동함으로써, 사용자에게 적절한 정보 또는 기능을 제공 또는 처리할 수 있다. 상기 프로세서(190)는, ASICs (application specific integrated circuits), DSPs(digital signal processors), DSPDs(digital signal processing devices), PLDs(programmable logic devices), FPGAs(field programmable gate arrays), 프로세서(processors), 제어기(controllers), 마이크로 컨트롤러(micro-controllers), 마이크로 프로세서(microprocessors), 기타 기능 수행을 위한 전기적 유닛 중 적어도 하나를 이용하여 구현될 수 있다. 도 1에 도시된 각 구성요소들 중 적어도 일부는, 이하에서 설명되는 다양한 실시 예들에 따른 전자 제어 장치(100)의 동작, 제어, 또는 제어방법을 구현하기 위하여 서로 협력하여 동작할 수 있다. 또한, 상기 전자 제어 장치(100)의 동작, 제어, 또는 제어방법은 메모리에 저장된 적어도 하나의 응용 프로그램의 구동에 의하여 전자 제어 장치(100) 상에서 구현될 수 있다. 일 예로, 상기 프로세서(190)는 상기 정맥 센서(130)에 의하여 생성된 손 영상에 근거하여 상기 햅틱 모듈(150)이 서로 다른 방식으로 동작하도록 상기 햅틱 모듈(150)을 제어할 수 있다. 나아가, 상기 프로세서(190)는 상기 손 영상에 근거하여 정맥 인증을 수행하고, 그에 따른 사용자 인터페이스를 제공할 수 있다. 도 2a 및 도 2b는 도 1에서 설명한 일부 구성 요소의 배치를 설명하기 위한 예시도이다. 도 2a는 상기 전자 제어 장치(100)를 위에서 아래로 바라본 상면도이고, 도 2b는 도 2a에 도시된 A 방향으로 바라본 측면도이다. 도 2a에 도시된 바와 같이, 상기 전자 제어 장치(100)의 상부에는 터치 패널(170)이 배치되고, 상기 터치 패널(170)의 가장자리에는 하나 또는 그 이 상의 햅틱 모듈들이 이격 배치될 수 있다. 도 2b에 도시된 바와 같이, 상기 터치 패널(170)의 배면에는 상기 정맥 센서(130) 및 상기 제스처 센서(160) 중 적어도 하나가 배치될 수 있다. 상기 정맥 센서(130) 및/또는 상기 제스처 센서(160)가 동작할 수 있도록, 상기 터치 패널(170)은 투명하게 이루어질 수 있다. 또는, 상기 터치 패널(170)은 중공을 가지며, 상기 중공과 오버랩 되는 위치에 상기 정맥 센서(130) 및 상기 제스처 센서(160) 중 적어도 하나가 배치될 수도 있다. 도면에 도시되지 않았으나, 상기 터치 패널(170)은 중공을 가지며, 상기 중공과 오보랩 되는 위치에 상기 햅틱 모듈(150)이 배치될 수 있다. 상기 햅틱 모듈(150)은 복수 개가 이격되어 배치될 수 있다. 이경우, 상기 프로세서(190)는 촉각 효과를 발생하기 위한 목표 지점 및 목표 세기를 산출하고, 상기 목표 지점에서 상기 목표 세기를 가지는 진동이 발생하도록, 각 햅틱 모듈의 출력 세기를 결정할 수 있다. 예를 들어, 제1 햅틱 모듈은 제1 주파수를 가지는 제1 초음파를 출력하고, 제2 햅틱 모듈은 제2 주파수를 가지는 제2 초음파를 출력할 수 있다. 상기 제1 초음파와 상기 제2 초음파가 교차하는 지점이 상기 목표 지점이 되며, 상기 목표 지점에서의 진동은 상기 제1 및 제2 초음파에 의하여 상기 목표 세기를 가진다. 상기 프로세서(190)는 상기 터치 패널(150)을 통해 탑승객의 터치 입력 및 상기 정맥 센서(130)를 통해 상기 탑승객의 정맥 정보를 동시에 수신할 수 있다. 상기 터치 패널(150)은 상기 전자 제어 장치(100)에서 생략될 수 있으며, 이경우, 상기 터치 패널(150)은 윈도우나 고무 패드로 대체될 수 있다. 상기 프로세서(190)는 상기 차량(1)에 탑승한 탑승객의 손을 감지한다. 상기 전자 제어 장치(100)와 이격된 3차원 공간이 정의되고, 상기 프로세서(190)는 상기 3차원 공간에 탑승객의 손이 위치하는지 여부를 결정할 수 있다. 나아가, 상기 프로세서(190)는 상기 3차원 공간의 좌표계에 근거하여 손 위치를 2차원 및/또는 3차원 좌표계로 환산할 수 있다. 여기서, 3차원 공간은 탑승객이 손가락 및 손의 움직임을 이용한 제스처 입력을 입력할 수 있는 공간을 의미하며, 눈에 보이지 않는 가상의 영역에 해당한다. 상기 상기 전자 제어 장치(100)는 상기 3차원 공간에 위치한 탑승객의 손을 추적할 수 있으며, 3차원 공간에 위치한 손가락 및/또는 손의 움직임에 따라 소정 기능이 실행되도록 제어 명령을 생성할 수 있다. 상기 3차원 공간은 있는 공간을 의본 발명에서는 설명의 편의를 위하여, 4a에 도시된 바와 같이, 3차원 공간이 육면체의 형태를 가지는 것으로 설명하나, 실시 예에 따라 다양한 크기 및 형태의 3차원 공간이 정의될 수 있다. 상기 전자 제어 장치(100)는 탑승객으로부터 사용자 입력을 수신하기 위한 것으로, 상기 차량(1)의 센터 페시아(center fascia)에 배치되거나, 상기 차량(1)에 구비된 운적석과 조수석 사이에 배치될 수 있다. 이로써, 운전자(driver) 및/또는 조수석 탑승객(front passenger)은 상기 전자 제어 장치(100)를 통해 상기 차량(1)과 관련된 다양한 기능들을 실행시킬 수 있다. 상기 프로세서(190)는 상기 정맥 센서(150)로부터 수신되는 손 영상을 이용하여 상기 손 위치를 산출할 수 있다. 상기 프로세서(190)가 상기 정맥 센서(130)로부터 상기 손 위치에 대한 손 위치 정보를 직접 수신하는 것도 가능하다. 상기 전자 제어 장치(100)는 탑승객의 손 및 손가락 중 적어도 하나의 움직임에 의하여 정의되는 제스처를 추적하는 제스처 센서(160)를 더 구비할 수 있다. 이경우, 상기 프로세서(190)는 상기 제스처 센서(160)를 이용하여 손의 위치를 감지할 수 있다. 상기 프로세서(190)는 상기 차량(1)에 구비된 카메라로부터 상기 차량(1)의 내부를 촬영한 내부 영상을 수신할 수도 있다. 이경우, 상기 프로세서(190)는 상기 내부 영상을 이용하여 상기 손 위치를 산출할 수 있다. 상기 전자 제어 장치(100)에 근접 센서가 더 구비될 수 있다. 상기 프로세서(190)는 상기 근접 센서에 의해 소정 물체가 상기 3차원 공간에 위치하는지를 검출하고, 상기 정맥 센서(130)를 이용하여 상기 소정 물체가 탑승객의 손에 해당하는지를 판단할 수 있다. 상기 근접 센서는 소정의 검출면에 접근하는 물체, 혹은 근방에 존재하는 물체의 유무를 전자계의 힘 또는 적외선 등을 이용하여 기계적 접촉이 없이 검출하는 센서를 말한다. 이러한 근접 센서는 위에서 살펴본 터치 패널(170)에 의해 감싸지는 전자 제어 장치(100)의 내부 영역 또는 상기 터치 패널(170)의 근처에 배치될 수 있다. 상기 프로세서(190)는 상기 차량(1)에 구비된 센서 및 상기 전자 제어 장치(100)에 구비된 센서 중 적어도 하나로부터 수신되는 센싱 정보를 종합적으로 고려하여 손의 위치를 산출할 수 있다. 다음으로, 상기 프로세서(190)는 상기 손에 위치한 정맥을 이용하여 정맥 인증을 수행할 수 있다. 정맥 인증은 상기 정맥 센서(130)에 의해 생성된 정맥 정보를 이용하여 탑승객을 식별하는 것을 의미한다. 상기 프로세서(190)는 적외선을 혈관에 투시한 후 잔영을 이용해 탑승객의 신분을 확인할 수 있다. 다시 말해, 상기 프로세서(190)는 상기 정맥 센서(130)로부터 생성된 손 영상 및/또는 정맥 정보를 이용하여 정맥 인증을 수행할 수 있다. 상기 프로세서(190)는 상기 전자 제어 장치(100)의 내부에 저장된 내부 식별 정보 및/또는 상기 전자 제어 장치(100)의 외부에 저장된 외부 식별 정보에 상기 정맥 센서(130)에 의해 생성된 정맥 정보를 비교함으로써 정맥 인증을 수행할 수 있다. 여기서, 상기 외부 식별 정보에는 상기 차량(1)에 구비된 메모리에 저장된 정보, 서버나 클라우드에 저장된 정보, 그리고 탑승객이 소지한 이동 단말기에 저장된 정보가 포함될 수 있다. 상기 전자 제어 장치(100)는 정맥 인증의 결과에 따라 서로 다른 인터페이스를 제공할 수 있다. 예를 들어, 탑승객이 상기 차량(1)을 이용할 권한이 있는 자인 경우, 상기 전자 제어 장치(100)는 상기 차량(1)에서 실행할 수 있는 모든 기능들에 접근할 수 있는 사용자 인터페이스를 제공할 수 있다. 이와 달리, 탑승객이 상기 차량(1)을 이용할 권한이 없는 자인 경우, 상기 전자 제어 장치(100)는 제한된 기능에만 접근할 수 있는 사용자 인터페이스를 제공할 수 있다. 정맥 인증의 결과에 따라 서로 다른 인터페이스가 제공되도록, 상기 프로세서(190)는 정맥 인증의 결과에 대응하는 사용자 모드를 실행할 수 있다. 나아가, 상기 프로세서(190)는 정맥 인증이 이루어지는 경우, 탑승객에 대응하는 사용자 모드가 상기 차량(1) 내 구비된 하나 또는 그 이상의 전장품들에서 실행되도록, 상기 통신부(110)를 제어할 수 있다. 상기 정맥 센서(130)에 의해 생성된 정맥 정보는 상기 전자 제어 장치(100) 및/또는 상기 차량(1)에 접속하기 위한 아이디와 암호의 역할을 수행한다. 다시 말해, 정맥 정보에 의하여 로그인이 이루어질 수 있다. 상기 프로세서(190)는 저장되어 있는 하나 또는 그 이상의 식별 정보들 중 정맥 정보와 매칭되는 어느 하나의 식별 정보를 탐색한다. 탐색된 식별 정보가 있는 경우, 탐색된 식별 정보에 대응하는 사용자 인터페이스를 제공하고, 탐색된 식별 정보가 없는 경우, 제한된 사용자 인터페이스를 제공한다. 상기 프로세서(190)는 상기 손의 위치에 근거하여 서로 다른 방식의 촉각 효과를 출력할 수 있다. 전자 제어 장치(100)의 구조에 따라 정맥 인증이 이루어질 수 있는 영역은 제한되어 있다. 예를 들어, 정맥 인증 가능 영역은 전자 제어 장치(100)가 손 영상을 획득할 수 있는 3차원 공간의 일부분에 형성될 수 있다. 정맥 인증은 상기 정맥 인증 가능 영역에 손이 위치한 경우에 한하여 이루어질 수 있다. 상기 프로세서(190)는 탑승객의 손이 상기 정맥 인증 가능 영역에 위치하도록 손의 이동 방향을 가이드 하는 촉각 효과를 발생시킬 수 있다. 상기 프로세서(190)는 상기 손이 상기 3차원 공간의 제1 영역에 위치하면 제1 방식의 촉각 효과가 발생하고 상기 손이 상기 3차원 공간의 제2영역에 위치하면 제2 방식의 촉각 효과가 발생하도록, 상기 햅틱 모듈(150)을 제어할 수 있다. 예를 들어, 손이 왼쪽으로 이동해야 하는 경우, 왼쪽을 가리키는 삼각형 형태의 촉각 효과가 발생하고, 손이 오른쪽으로 이동해야 하는 경우, 오른쪽을 가리키는 삼각형 형태의 촉각 효과가 발생할 수 있다. 손이 상기 정맥 인증 가능 영역에 위치하는 경우, 원형 형태의 촉각 효과가 발생할 수 있다. 여기서, 특정 형태의 촉각 효과는 사용자가 촉감을 통하여 상기 특정 형태를 직감 및/또는 인식할 수 있는 것을 의미한다. 동일한 형태의 촉각 효과라도, 손이 상기 정맥 인증 가능 영역에 가까워질수록 더 큰 세기의 촉각 효과가 발생하고, 상기 정맥 인증 가능 영역에 멀어질수록 더 작은 세기의 촉각 효과가 발생할 수 있다. 다시 말해, 상기 프로세서(190)는 상기 정맥 센서(130)와 손 사이의 거리에 따라 서로 다른 크기의 진동이 발생하도록 상기 햅틱 모듈(150)를 제어할 수 있다. 손의 위치는 상호 직교하는 3축으로 이루어진 좌표계로 나타낼 수 있다. 예를 들어, 손의 위치는 x축, y축, z축으로 표현될 수 있다. 이경우, 상기 프로세서(190)는 손의 x 좌표, y좌표 및 z 좌표 중 적어도 하나에 따라 서로 다른 촉각 효과가 발생하도록 상기 햅틱 모듈(150)을 제어할 수 있다. 탑승객은 촉각 효과를 따라 정맥 인증이 가능한 상기 정맥 인증 가능 영역으로 손을 이동시킬 수 있다. 상기 프로세서(190)는 상기 정맥 인증이 완료되면 출력 중이던 촉각 효과의 출력을 종료하고, 상기 정맥 인증에 따라 상기 탑승객에게 서로 다른 권한을 부여할 수 있다. 정맥 인증이 완료되지 않으면, 상기 프로세서(190)는 손의 위치에 근거하여 서로 다른 방식의 촉각 효과가 발생하도록 상기 햅틱 모듈(150)을 제어한다. 정맥 인증이 완료되면, 상기 프로세서(190)는 출력 중이던 촉각 효과의 출력을 종료한다. 이후, 상기 프로세서(190)는 정맥 인식의 성공 또는 실패를 가이드 하는 촉각 효과를 추가적으로 발생시킬 수 있다. 정맥 인증이 성공하는 경우, 특정 아이디에 의한 로그인이 이루어지며 특정 아이디에 대응하는 사용자 인터페이스가 제공된다. 이와 달리, 정맥 인증이 실패하는 경우, 로그인 실패에 따른 제한된 사용자 인터페이스가 제공된다. 사용자 인터페이스는 탑승객이 이용할 수 있는 복수의 기능들을 가이드 하는 메뉴(또는, 애플리케이션들을 실행시킬 수 있는 아이콘들)를 포함하며, 메뉴의 구성, 메뉴의 형태, 및 배경 이미지 중 적어도 하나가 정맥 인증에 이용된 정맥 정보에 따라 달라진다. 본 발명에 따르면 정맥 인증을 이용하여 탑승객에게 서로 다른 사용자 인터페이스를 제공할 수 있으며, 정맥 인증이 원활히 이루어지도록 정맥 인증 가능 영역을 가이드 하는 촉각 효과를 발생시키기 때문에 사용자는 정확한 위치로 손을 이동시킬 수 있다. 정맥 인증 가능 영역은 눈에 보이지 않는 가상의 공간이지만, 손의 위치에 따라 적절한 촉각 효과가 공기의 진동을 통해 탑승객에게 전달된다. 이로써, 운전자는 어느 손으로 운전을 수행하며 전방을 주시하면서도 다른 손으로 정맥 인증을 수행할 수 있다. 상기 프로세서(190)는 손 위치에 따라 촉각 효과의 햅틱 강도를 다양한 방식으로 조절할 수 있다. 예를 들어, 탑승객의 손이 3차원 공간의 가장자리에 위치하는 경우 촉각 효과가 발생하며, 탑승객의 손이 정맥 인증 가능 영역에 다가갈수록 더 강한 세기의 촉각 효과가 발생할 수 있다. 다른 예를 들어, 3차원 공간의 가장자리를 가이드 하기 위하여, 탑승객의 손이 3차원 공간의 가장자리에 위치하는 경우 가장 큰 세기의 촉각 효과가 발생하고, 정맥 인증 가능 영역의 가장자리에 위치하는 경우 가장 약한 세기의 촉각 효과가 발생하고, 정맥 인증 가능 영역의 중앙에 위치하는 경우 중간 세기의 촉각 효과가 발생할 수 있다. 도 3은 도 1의 전자 제어 장치에 의한 제어방법을 설명하기 위한 흐름도이고, 도 4a 및 도 4b는 도 3의 제어방법을 설명하기 위한 예시도들이다. 상기 프로세서(190)는 차량에 탑승한 탑승객의 시선을 추적한다(S310). 탑승객은 운전자를 포함하며, 앞 좌석에 탑승한 탑승객뿐만 아니라 뒷 좌석에 탑승한 탑승객을 포함할 수 있다. 상기 프로세서(190)는 하나 또는 그 이상의 탑승객들에 대하여 시선 추적을 수행할 수 있다. 예를 들어, 제1 탑승객에 대한 제1 시선과 제2 탑승객에 대한 제2 시선을 동시에 추적할 수 있다. 상기 프로세서(190)는 차량(1)의 시동이 켜지면 탑승객의 시선 추적, 즉 아이트래킹(eye tracking)을 활성화하고, 시선을 실시간으로 추적 한다. 아이트래킹은 눈동자의 움직임을 감지하여 시선을 추적하는 기술로서, 이미지 분석 방식, 콘택트 렌즈 방식, 센서 부착 방식 등이 있다. 비디오 분석 방식은 카메라에 포착된 이미지의 분석을 통해 눈동자의 움직임을 검출하고, 검출된 움직임으로부터 운전자의 시선을 산출한다. 콘택트 렌즈 방식은 거울 내장 콘택트 렌즈의 반사된 빛이나 코일 내장 콘택트 렌즈의 자기장을 이용하여 운전자의 시선을 산출한다. 센서 부착 방식은 운전자의 눈 주위에 센서를 부착하여 눈의 움직임에 따른 전기장을 변화를 감지하고, 감지된 변화에 근거하여 운전자의 시선을 산출한다. 차량(1) 및/또는 전자 제어 장치(100)는 차량에 탑승한 탑승객의 시선을 추적하는 센서를 구비한다. 센서가 탑승객의 시선을 추적하여 그 결과를 상기 프로세서(190)로 전송하거나, 상기 프로세서(190)가 센서로부터 수신되는 정보를 이용하여 탑승객의 시선을 추적할 수 있다. 상기 이미지 센서(120)는 상기 전자 제어 장치(100)에 구비되거나, 상기 차량(1)에 구비될 수 있다. 상기 이미지 센서(120)가 상기 차량(1)에 구비되는 경우, 상기 프로세서(190)는 상기 통신부(110)를 통해 상기 이미지 센서(120)로부터 아이트래킹 정보를 수신하고, 상기 아이트래킹 정보에 근거하여 시선을 추적할 수 있다. 다음으로, 상기 프로세서(190)는 상기 시선이 향하는 오브젝트를 탐색한다(S330). 상기 프로세서(190)는 추적된 탑승객의 시선에 근거하여 탑승객이 바라보고 있는 특정 물체를 오브젝트로 탐지할 수 있다. 탑승객의 시선이 차량 내부를 향하는 경우, 탑승객이 차량 내부의 어떤 물체를 바라보고 있는지 탐지될 수 있다. 구체적으로, 상기 프로세서(190)는 메모리에 저장된 2차원 및/또는 3차원 좌표계를 이용하여 탑승객이 바라보고 있는 특정 물체를 추출할 수 있다. 예를 들어, 소정 범위의 좌표 범위내에 볼륨 조절 장치가 위치하고, 탑승객의 시선이 상기 소정 범위 내에 위치하면, 상기 프로세서(190)는 탑승객이 상기 볼륨 조절 장치를 바라보고 있는 것으로 판단할 수 있다. 탑승객의 시선이 윈드실드 밖의 차량 외부를 향하는 경우에도, 상기 프로세서(190)는 탑승객이 차량(1) 외부의 어떤 물체를 바라보고 있는지를 탐지할 수 있다. 예를 들어, 상기 프로세서(190)는 메모리에 저장된 좌표계를 이용하여 운전자의 시선 위치를 산출하고, 산출된 시선 위치에 어떤 물체가 위치하는지를 탐색할 수 있다. 이경우, 상기 프로세서(190)는 차량(1) 외부를 향하는 카메라, 레이더, 라이더 등의 센서를 이용하여 시선에 위치하는 물체를 탐지하고, 차량(1)과 탐색된 물체 사이의 거리, 물체의 크기, 색상, 속도, 종류 등의 정보를 탐색할 수 있다. 상기 프로세서(190)는, 탑승객의 시선이 차량(1) 내부를 향하는 경우, 시선에 근거하여 차량(1)에 구비된 복수의 디스플레이들 중 어느 하나를 선택할 수 있다. 다양한 정보들이 출력되는 복수의 디스플레이들 중 탑승객이 바라보고 있는 어느 하나의 디스플레이가 선택된다. 나아가, 상기 프로세서(190)는 탑승객이 어느 하나의 디스플레이를 소정시간 동안 응시하는 경우, 상기 어느 하나에서 출력되고 있는 복수의 콘텐츠들 중 탑승객이 응시하고 있는 적어도 일부의 콘텐츠를 선택할 수 있다. 예를 들어, 상기 어느 하나의 디스플레이에는 분리 가능한 복수의 컨텐츠들이 표시될 수 있고, 상기 프로세서ㅒ(190)는 상기 시선에 근거하여 상기 복수의 컨텐츠들 중 적어도 하나를 상기 오브젝트로 선택할 수 있다. 상기 오브젝트는 하나 또는 그 이상의 기능들에 연계된 것이며, 탑승객의 제스처에 의하여 연계된 기능 중 적어도 하나가 선택적으로 실행될 수 있다. 연계된 기능이 없는 물체는 오브젝트로 탐색되지 않는다. 다음으로, 상기 프로세서(190)는 상기 탑승객의 제스처를 추적한다(S350). 본 발명에서는 상기 프로세서(190)가 상기 전자 제어 장치(100)에 구비된 상기 제스처 센서(160)를 이용해 탑승객의 제스처를 추적하는 것을 예로 들어 설명하나, 이에 한정되는 것은 아니다. 차량(1) 및/또는 전자 제어 장치(100)는 차량에 탑승한 탑승객의 제스처를 추적하는 센서를 구비한다. 센서가 탑승객의 제스처를 추적하여 그 결과를 상기 프로세서(190)로 전송하거나, 상기 프로세서(190)가 센서로부터 수신되는 정보를 이용하여 탑승객의 제스처를 추적할 수 있다. 상기 프로세서(190)는 상기 제스처 센서(160)를 이용하여 상기 탑승객의 손 및 손가락 중 적어도 하나의 움직임에 의하여 정의되는 제스처를 추적할 수 있다. 상기 프로세서(190)는 상기 제스처가 기준 조건을 만족하는 것에 응답하여 상기 오브젝트에 연관된 기능들 중 상기 제스처에 대응하는 어느 하나의 기능을 실행한다(S370). 상기 프로세서(190)는 상기 탑승객의 제스처가 기준 조건을 만족하는지를 판단할 수 있다. 예를 들어, 검지를 허공에서 두 번 연속적으로 두드려야 하는 제1조건, 오케이 형태가 되도록 엄지와 검지를 맞닿은 상태에서 중지, 약지, 새끼 손가락를 펼쳐야 하는 제2 조건, 모든 손가락을 쫙 펼친 상태에서 손바닥을 제1방향으로 향하게 해야 하는 제3조건, 검지와 중지가 영문자 v가 되도록 해야 하는 제4조건 등등이 기준 조건으로 설정될 수 있다. 상기 프로세서(190)는 상기 탑승객의 제스처가 메모리 등에 저장되어 있는 기준 제스처들 중 어느 하나에 매칭되는지를 판단하고(또는 기준 조건에 만족하는지를 판단하고), 상기 어느 하나에 매칭되는 경우 그에 설정된 기능을 실행할 수 있다. 도 4a 및 도 4b에 도시된 바와 같이, 차량(1)에는 디스플레이(400)가 구비되고, 상기 디스플레이(400)에는 제1그래픽 객체(410)와 제2그래픽 객체(420)가 표시될 수 있다. 도4a에 도시된 바와 같이, 탑승객의 시선이 제2 그래픽 객체(420)를 향하는 경우, 상기 프로세서(190)는 상기 제2 그래픽 객체(420)를 선택한다. 나아가, 상기 탑승객의 제스처가 제1지점에서 제2지점으로 이동하는 것이면, 이동 방향에 따라 상기 제2 그래픽 객체(420)와 관련된 서로 다른 기능이 실행될 수 있다. 일 예로, y축 양의 방향으로 이동하는 경우, 상기 제2 그래픽 객체(420)의 크기가 제스처의 이동 거리에 따라 점차 커질 수 있다. 도면에 도시되지 않았으나, 제스처가 y축 음의 방향으로 이동하는 경우, 상기 제2 그래픽 객체(420)의 크기가 제스처의 이동 거리에 따라 작아질 수 있다. 제2 그래픽 객체(420)의 크기가 변함에 따라, 제1 그래픽 객체(410)의 크기도 달라질 수 있다. 도면에 도시되지 않았으나, 상기 탑승객의 시선에 의하여 상기 제2 그래픽 객체(420)가 선택된 상태에서, x축 방향으로 이동하는 제스처가 수신되는 경우, 상기 프로세서(190)는 스크롤 기능을 수행할 수 있다. 도4b에 도시된 바와 같이, 탑승객의 시선이 제1 그래픽 객체(410)를 향하는 경우, 상기 프로세서(190)는 상기 제1 그래픽 객체(410)를 선택하고, 이후 입력되는 제스처에 응답하여 상기 제1 그래픽 객체(410)와 관련된 기능을 실행한다. 이때 실행되는 기능은 상기 제스처에 따라 가변될 수 있다. 본 발명에 따른 전자 제어 장치의 동작을 마우스 커서를 예로 들어 설명한다. 마우스 커서는 탑승객의 시선에 대응하고, 마우스에 입력되는 좌 클릭, 클릭, 더블 클릭, 스크롤, 드래그 등의 사용자 입력은 탑승객의 제스처 입력에 대응한다. 마우스 커서가 놓여 있는 위치의 오브젝트를 탐색하고, 이후 입력되는 마우스 입력에 따라 상기 오브젝트와 관련된 서로 다른 기능이 실행될 수 있다. 마찬가지로, 시선에 근거하여 오브젝트를 탐색하고, 이후 입력되는 제스처 입력에 따라 상기 오브젝트와 관련된 서로 다른 기능이 실행될 수 있다. 탑승객이 무엇을 바라보는지에 따라 오브젝트가 달라지고, 오브젝트에 따라 실행될 수 있는 기능들의 종류가 달라진다. 어느 오브젝트가 선택된 상태에서 실제 실행되는 기능은 탑승객의 제스처에 따라 달라진다. 시선의 변경으로 오브젝트가 변경되지 않는 한, 시선에 의해 오브젝트가 선택된 시점으로부터 소정 시간 이내에 기준 조건을 만족하는 제스처가 입력되는 경우에 적어도 하나의 기능이 실행될 수 있다. 상기 소정 시간이 지난 후 기준 조건을 만족하는 제스처가 입력되는 경우 상기 적어도 하나의 기능은 실행되지 않는다. 이는, 탑승객이 의도하지 않은 기능이 실행되는 것을 방지하기 위함이다. 차량의 특성상 운전자는 운전석 근처에 배치된 장치들을 제어할 수 있지만, 조수석 근처에 배치된 장치들을 제어하기 어려운 문제가 있다. 공간의 제약으로 손이 닿지 않는 영역에 각종 장치들이 배치되기 때문이다. 허나 본 발명은 시선을 통해 오브젝트를 특정하고, 허공에서 움직이는 제스처에 근거하여 상기 오브젝트와 관련된 다양한 기능들을 실행할 수 있기 때문에 상술한 문제가 해결된다. 탑승객은 앉은 자리에서 손에 닿지 않는 장치에 대하여 특정 기능을 실행시킬 수 있다. 나아가, 다양한 제스처를 이용해 다양한 기능을 실행시킬 수 있다. 이하에서는 시선에 의하여 탐색된 오브젝트와 관련된 다양한 기능들을 실행시키는 방법에 대하여 살펴본다. 도 5는 복수의 기능들 중 어느 하나의 기능을 탑승객으로부터 선택받기 위한 가상의 구역들을 제공하는 제어방법을 설명하기 위한 흐름도이다. 상기 프로세서(190)는 소정 공간에 시선이 향하는 오브젝트에 연관된 기능들에 대응하는 복수의 구역들을 설정한다(S510). 상기 프로세서(190)는 상기 탑승객의 시선에 의해 선택된 오브젝트에 근거하여 상기 소정 공간에 자연수인 n개의 구역들을 설정하며, 상기 n은 상기 시선이 향하는 상기 오브젝트에 따라 달라진다 . 예를 들어, 제1 오브젝트에 연계된 기능들이 2개인 경우, 2개의 구역들이 설정되고, 제2 오브젝트에 연계된 기능들이 6개인 경우, 6개의 구역들이 설정될 수 있다. 구역들의 개수는 상기 탑승객의 시선에 의하여 선택된 오브젝트에 따라 달라진다. 상기 복수의 구역들은 2차원 또는 3차원 행렬을 형성할 수 있다 . 본 발명에서는 각 구역이 육면체로 형성된 것을 예로 들어 설명하나, 이에 한정되는 것은 아니며 다양한 형태의 구역들이 형성될 수 있다. 상기 복수의 구역들은 가상의 공간에 형성되는 것으로, 탑승객의 눈에는 확인되지 않는다. 본 발명에 따른 전자 제어 장치(100)는 상기 복수의 구역들을 가이드 하기 위하여 시각적 정보 및/또는 촉각적 정보를 제공할 수 있다. 상기 복수의 구역들을 탑승객에게 가이드 하기 위하여, 상기 프로세서(190)는 복수의 구역들을 가이드 하는 영상이 차량(1)에 구비된 디스플레이(10)에서 표시되도록 통신부(110)를 제어할 수 있다(S530). 상기 영상은 각 구역들의 위치, 크기 및 형태를 가이드 하도록 이루어진다. 예를 들어, 소정 공간에 n개의 구역들이 형성되면, 상기 영상은 상기 n개의 구역들을 가이드 하도록 이루어진다 . 각 구역에는 서로 다른 기능이 연계되며, 상기 영상에는 각 구역에 연계된 기능이 무엇인지를 설명하는 상세정보가 추가적으로 포함될 수 있다. 나아가, 상기 프로세서(190)는 상기 영상에 손의 위치를 가이드 하는 그래픽 객체가 표시되도록 통신부(110)를 제어할 수 있다(S550). 상기 탑승객의 손이 상기 3차원 공간 내에 있으면, 상기 프로세서(190)가 상기 손을 추적할 수 있기 때문에, 상기 영상에 상기 그래픽 객체를 표시할 수 있다. 상기 탑승객의 손이 상기 3차원 공간 밖에 있으면, 상기 그래픽 객체는 상기 영상 위에 표시되지 않게 된다. 상기 그래픽 객체는 손 이미지일 수 있다. 상기 영상 위에 표시되는 상기 그래픽 객체의 형태는 상기 탑승객의 손이 만들어내는 형태에 따라 달라진다. 예를 들어, 탑승객의 손이 오케이 형태를 만들면, 상기 그래픽 객체도 오케이 형태의 손 이미지가 된다. 다른 예를 들어, 탑승객의 손가락들이 모두 펼쳐진 형태이면, 상기 그래픽 객체도 손가락들이 모두 펼쳐진 손 이미지일 수 있다. 상기 프로세서(190)는 상기 제스처 센서(160)를 이용하여 상기 탑승객의 손의 형태를 결정하고, 상기 결정된 형태의 손 이미지가 상기 영상 위에 표시되도록 상기 통신부(110)를 제어할 수 있다. 상기 프로세서(190)는, 상기 n개의 구역들 중 제1구역에 상기 탑승객의 손이 위치하는 경우, 상기 영상에서 상기 제1구역에 하이라이트가 이루어지도록 상기 통신부를 제어할 수 있다 . 이를 통해, 탑승객은 눈에 보이지 않는 가상의 공간에서 자신의 손이 어느 구역에 위치하는지를 직관적으로 인식할 수 있다. 상기 프로세서(190)는, 상기 영상이 표시된 상태에서 기설정된 제스처가 감지되는 경우, 상기 n개의 구역들을 회전 이동시켜 각 구역의 위치를 재설정할 수 있다 . 예를 들어, 운전석에서 조수석을 향하는 방향으로, 제1 내지 제4구역들이 순차적으로 형성될 수 있다. 이경우, 제1 내지 제4구역들에 의하여, 1X4 형태의 행렬이 이루어진다. 제1구역은 운전자에게 가깝게 위치하지만, 제4구역은 운전자에게 멀게 위치한다. 이경우, 운전자는 제4 구역은 자신에게 가깝게 위치하도록 상기 1X4 형태의 행령을 180도 회전시킬 수 있다. 회전에 의하여, 제1구역이 제4구역으로 이동하고 제4구역이 제1구역으로 이동하며, 제2구역이 제3구역으로, 제3구역이 제2구역으로 이동한다. 탑승객은 자신에게 최적화된 형태로 각 구역의 위치를 재설정할 수 있기 때문에, 탑승객 편의성이 증대된다. 한편, 상기 프로세서(190)는 기준 조건을 만족하는 제스처가 상기 복수의 구역들 중 어느 하나의 구역에서 수신되는 것에 응답하여 상기 어느 하나의 구역에 대응하는 기능을 실행할 수 있다(S570). 복수의 구역들 각각에는 서로 다른 기능이 연계될 수 있다. 예를 들어, 제1 구역 및 제2 구역 각각에는 제1 기능 및 제2 기능이 연계될 수 있다. 상기 제2 구역에서 기준 조건을 만족하는 제스처가 수신되는 경우, 상기 프로세서(190)는 상기 제2 구역에 연계된 제2 기능을 실행한다. 기준 조건을 만족하는 제스처는, 예를 들어, 검지가 허공을 연속적으로 두 번 두드리는 것일 수 있다. 상기 기준 조건을 만족하는 제스처는 실시 예에 따라 다양하게 변형될 수 있다. 한편, 상기 프로세서(190)는 상기 복수의 구역들을 가이드 하기 위한 촉각적 정보를 제공할 수도 있다. 예를 들어, 공기의 진동을 이용하여 촉각 효과를 발생시키는 햅틱 모듈(150)을 이용하여 촉각 효과를 발생시킬 수 있다. 상기 프로세서(190)는 상기 탑승객의 손이 제1구역에 위치하는 경우, 제1방식의 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어하고, 제2 구역에 위치하는 경우 제2 방식의 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어할 수 있다. 상기 탑승객은 손에서 느껴지는 촉감에 의하여, 자신의 손이 어디에 위치하는지를 인지할 수 있다. 나아가, 상기 프로세서(190)는 상기 탑승객의 손이 상기 어느 하나의 구역의 가장자리에 위치하면 제1크기의 진동이 발생하고, 상기 어느 하나의 구역의 중앙에 위치하면 상기 제1크기보다 큰 제2크기의 진동이 발생하도록 상기 햅틱 모듈을 제어할 수 있다 . 탑승객은 손을 이동해 가며 자신의 손이 어디쯤에 위치하는지를 정확히 인지할 수 있다. 도 6은 탑승객의 시선이 디스플레이를 향하는 경우의 제어방법을 설명하기 위한 흐름도이고, 도 7a 및 도 7b는 도 6의 제어방법을 설명하기 위한 예시도들이다. 프로세서(190)는 시선이 차량에 구비된 디스플레이를 향하는 경우, 상기 시선에 근거하여 상기 디스플레이에 포함된 복수의 그래픽 객체들 중 어느 하나를 오브젝트로 탐색할 수 있다 (S610). 상기 디스플레이에는 분리 가능한 복수의 그래픽 객체들이 출력될 수 있다. 이경우, 프로세서(190)는 탑승객의 시선에 근거하여 상기 복수의 그래픽 객체들 중 적어도 하나를 선택할 수 있다. 예를 들어, 상기 디스플레이(400)에는 제1 그래픽 객체(410) 및 제2 그래픽 객체(420)가 표시될 수 있다. 도 7a에 도시된 바와 같이, 상기 탑승객의 시선이 제1 그래픽 객체(410)를 향하는 경우, 상기 프로세서(190)는 제1 그래픽 객체(410)를 오브젝트로 탐색한다. 이와 달리, 도 7b에 도시된 바와 같이, 상기 탑승객의 시선이 제2 그래픽 객체(420)를 향하는 경우, 상기 프로세서(190)는 제2 그래픽 객체(420)를 오브젝트로 탐색한다. 프로세서(190)는 상기 오브젝트가 탐색되는 경우, 상기 오브젝트와 관련된 상세정보가 상기 디스플레이에 표시되도록 통신부(110)를 제어할 수 있다 (S630). 선택이 이루어지면, 선택된 적어도 일부의 그래픽 객체를 안내하는 상세정보가 출력된다. 상기 상세정보를 통해 탑승객은 어떤 그래픽 객체가 선택되어 있는지를 확인할 수 있다. 상기 상세정보에는 상기 오브젝트와 관련해 탑승객이 실행할 수 있는 기능의 개수, 복수의 구역들, 각 구역에 설정된 기능, 각 구역에 설정된 기능을 실행하기 위해 필요한 제스처 등이 포함될 수 있다. 제1 그래픽 객체(410)에 2개의 기능들이 연계되어 있는 경우, 상기 프로세서(190)는 두 개의 구역들(710)을 형성하고, 상기 두 개의 구역들에 대한 상세정보(712)를 상기 디스플레이(400)에 출력할 수 있다. 제2 그래픽 객체(420)에 4개의 기능들이 연계되어 있는 경우, 상기 프로세서(190)는 네 개의 구역들(720)을 형성하고, 상기 네 개의 구역들에 대한 상세정보(714)를 상기 디스플레이(400)에 출력할 수 있다. 탑승객은 가상의 공간을 통해 사용자 입력을 입력하지만, 디스플레이를 통해 상기 가상의 공간에 대한 정보가 제공되기 때문에, 사용자는 편리하게 상기 사용자 입력을 입력할 수 있다. 도 8은 도 5에서 설명한 가상의 구역들을 가변시키는 제어방법을 설명하기 위한 흐름도이고, 도 9a, 9b, 9c 및 9d는 도 8의 제어방법을 설명하기 위한 예시도들이다. 상기 프로세서(190)는 오브젝트에 연관된 기능들 각각에 설정되어 있는 설정 값에 따라 각 구역의 크기 및 위치 중 적어도 하나를 조정할 수 있다 (S810). 예를 들어, 제1 오브젝트에 대하여, 제1 내지 제3 기능들이 연계될 수 있다. 상기 프로세서(190)는 상기 탑승객이 상기 제1 오브젝트를 바라보는 경우, 제1 내지 제3 기능들에 대응하는 3개의 구역들을 1X3 형태의 행렬로 설정할 수 있다. 좌측에서 우측으로 제1 내지 제3 구역들이 배치되고, 각 구역에는 각 기능이 연계될 수 있다. 상기 제1 내지 제3 기능들에 대하여 동일한 설정 값이 설정되어 있는 경우, 도 9a에 도시된 바와 같이, 동일한 크기와 동일한 형태의 구역들이 소정 공간에 설정될 수 있다. 이와 달리, 도 9b에 도시된 바와 같이, 상기 제1 내지 제3 기능들에 대하여 서로 다른 설정 값이 설정되어 있는 경우에는 서로 다른 크기 및/또는 서로 다른 형태의 구역들이 소정 공간에 설정될 수 있다. 다시 말해, 상기 프로세서(190)는 오브젝트에 연관된 기능들 각각에 설정되어 있는 설정 값에 따라 각 구역의 크기 및 위치 중 적어도 하나를 결정하고, 그 결과에 따라 소정 공간에 복수의 구역들을 설정할 수 있다. 상기 프로세서(190)는 기능들 각각이 실행된 횟수에 근거하여 설정 값을 업데이트 할 수 있다 (S830). 상기 프로세서(190)는 탑승객이 실행시킨 기능의 히스토리를 메모리에 저장하고, 자주 실행시킨 기능을 더 빠르게 선택하고 실행시킬 수 있도록, 자주 실행시킨 기능의 설정 값을 업데이트 한다. 예를 들어, 도 9a에 도시된 바와 같이, 3가지 기능들에 대하여 동일한 설정 값이 설정된 상태에서, 제1 기능이 i번 실행되고, 제2기능이 i보다 작은 j번 실행되고, 제3 기능은 실행되지 않을 수 있다. 이경우, 도 9b에 도시된 바와 같이, 제2 기능에 대응하는 제2 구역의 크기는 유지되지만, 제1 기능에 대응하는 제1 구역의 크기는 커지고, 제3 기능에 대응하는 제3 구역의 크기는 작아질 수 있다. 자주 사용하는 기능에 대응하는 구역의 크기가 다른 구역에 비해 크기 때문에, 탑승객은 보다 빠르게 자주 사용하는 기능을 실행시킬 수 있다. 제스처를 입력하기 위해 손을 이동시켜야 하는 거리가 줄어들기 때문이다. 한편, 상기 프로세서(190)는 동일한 오브젝트를 바라보더라도 탑승객에 따라 서로 다른 방식으로 복수의 구역들을 설정할 수 있다. 상기 복수의 구역들이 형성되는 공간을 소정 공간이라고 정의하면, 상기 소정 공간은 상기 탑승객을 기준으로 정의되며, 상기 소정 공간의 크기 및 위치 중 적어도 하나는 상기 탑승객에 따라 달라질 수 있다 . 예를 들어, 도 9c에 도시된 바와 같이, 제1 탑승객이 제1 오브젝트를 바라보는 경우, 8개의 구역들이 제1공간(910) 내에서 설정될 수 있다. 이와 달리, 도 9d에 도시된 바와 같이, 제2 탑승객이 제1 오브젝트를 바라보는 경우, 8개의 구역들이 제2공간(920) 내에서 설정될 수 있다. 탑승객에 따라 팔 길이가 다르므로, 상기 소정 공간은 탑승객이 제스처를 입력하기에 최적인 크기와 위치에서 형성되고, 따라서 상기 소정 공간의 위치 및 크기 중 적어도 하나는 탑승객에 따라 달라진다. 상기 소정 공간이 달라짐에 따라, 상기 소정 공간에 포함되는 복수의 구역들 각각의 크기도 달라질 수 있다. 상기 프로세서(190)는 상기 탑승객이 제1 탑승객인 경우 각 구역의 크기를 제1크기로 설정하고, 상기 탑승객이 제2 탑승객인 경우, 각 구역의 크기를 상기 제1크기와 다른 제2크기로 설정할 수 있다 . 노약자의 경우, 제스처를 입력함에 있어 미세한 움직임이 불가능할 수 있기 때문에, 각 구역의 크기가 다른 탑승객에게 설정된 크기 보다 커지도록 제어할 수 있다. 도 10a 및 도 10b는 트리거 제스처에 따라 가상의 구역들이 형성되는 위치가 달라지는 예를 설명하기 위한 예시도들이다. 탑승객은 눈을 뜨고 있는 이상 계속해서 다양한 물체를 바라볼 수 밖에 없다. 탑승객이 바라보는 모든 물체를 추적하게 되는 경우, 불필요하게 전원을 소모하는 문제가 발생한다. 탑승객이 특정 기능을 실행하고자 하는 때에만, 탑승객이 바라보는 물체를 오브젝트로 탐지하고, 그에 대응하는 구역들을 설정한다면, 전자 제어 장치(100)는 에너지를 효율적으로 사용할 수 있게 된다. 이를 위해, 상기 프로세서(190)는 기설정된 트리거 제스처가 감지되는 것에 응답하여 상기 소정 공간에 상기 복수의 구역들을 설정하며, 상기 트리거 제스처가 감지된 위치에 근거하여 상기 소정 공간의 중심점을 설정할 수 있다. 트리거 제스처는 제스처를 입력하기 위한 시작 행위로써, 트리거 제스처가 입력된 위치에서 추가적인 제스처가 입력되는 것이 탑승객에게 편리함을 제공한다. 따라서, 상기 프로세서(190)는 트리거 제스처가 감지된 위치에 근거하여 상기 소정 공간의 중심점을 설정할 수 있다. 예를 들어, 도 10a에 도시된 바와 같이, 제1 지점에서 트리거 제스처가 입력되는 경우, 제1 지점을 중심점으로 하여 소정 공간(1010)이 설정되고, 도 10b에 도시된 바와 같이, 제2 지점에서 트리거 제스처가 입력되는 경우, 제2 지점을 중심점으로 하여 소정 공간(1020)이 설정될 수 있다. 트리거 제스처가 입력되어야 구역들이 설정되고, 구역의 중심점이 트리거 제스처에 의하여 결정되기 때문에, 전자 제어 장치가 불필요하게 동작하는 것이 차단되며, 사용자 중심의 인터페이스가 제공된다. 도 11은 가상의 구역들에 대한 촉각 효과를 제공하는 제어방법을 설명하기 위한 흐름도이고, 도 12a 및 도 12b는 도 11의 제어방법을 설명하기 위한 예시도들이다. 상기 프로세서(190)는 복수의 구역들이 설정된 상태에서 상기 복수의 구역들에 대하여 손가락의 위치를 탐색할 수 있다(S1110). 상기 프로세서(190)는 상기 이미지 센서(120), 상기 정맥 센서(130) 및 상기 제스처 센서(160) 중 적어도 하나를 이용하여 손가락의 위치를 탐색할 수 있다. 상기 손가락의 위치는 2차원 및/또는 3차원 좌표계의 좌표 값을 산출될 수 있다. 상기 프로세서(190)는 손가락의 위치에 근거하여 서로 다른 촉각 효과를 생성할 수 있다(S1130). 상기 프로세서(190)는 탑승객의 손이 상기 복수의 구역들 중 어느 하나에 위치하도록 손의 이동 방향을 가이드 하는 촉각 효과를 발생시킬 수 있다. 상기 프로세서(190)는 상기 손이 상기 3차원 공간의 제1 영역에 위치하면 제1 방식의 촉각 효과가 발생하고 상기 손이 상기 3차원 공간의 제2영역에 위치하면 제2 방식의 촉각 효과가 발생하도록, 상기 햅틱 모듈(150)을 제어할 수 있다. 예를 들어, 도 12a에 도시된 바와 같이, 손가락이 어느 하나의 구역(1210) 중심에 위치하는 경우, 원형 형태의 촉각 효과(1220)가 발생할 수 있다. 도 12b에 도시된 바와 같이, 손이 왼쪽으로 이동해야 하는 경우, 왼쪽을 가리키는 삼각형 형태의 촉각 효과(1230)가 발생할 수 있다. 도면에 도시되지 않았으나, 손이 오른쪽으로 이동해야 하는 경우, 오른쪽을 가리키는 삼각형 형태의 촉각 효과가 발생할 수 있다. 여기서, 특정 형태의 촉각 효과는 사용자가 촉감을 통하여 상기 특정 형태를 직감 및/또는 인식할 수 있는 것을 의미한다. 동일한 형태의 촉각 효과라도, 손이 상기 어느 하나의 구역(1210)의 중심에 가까워질수록 더 큰 세기의 촉각 효과가 발생하고, 상기 중심에서 멀어질수록 더 작은 세기의 촉각 효과가 발생할 수 있다. 다시 말해, 상기 프로세서(190)는 상기 구역(1210)의 중심점과 손 사이의 거리에 따라 서로 다른 크기의 진동이 발생하도록 상기 햅틱 모듈(150)를 제어할 수 있다. 손의 위치는 상호 직교하는 3축으로 이루어진 좌표계로 나타낼 수 있다. 예를 들어, 손의 위치는 x축, y축, z축으로 표현될 수 있다. 이경우, 상기 프로세서(190)는 손의 x 좌표, y좌표 및 z 좌표 중 적어도 하나에 따라 서로 다른 촉각 효과가 발생하도록 상기 햅틱 모듈(150)을 제어할 수 있다. 도 13은 복수의 탑승객들이 탑승한 경우 전자 제어 장치의 동작을 설명하기 위한 개념도이다. 본 발명에 따른 전자 제어 장치(100)는 복수의 탑승객들이 탑승하는 경우, 각 탑승객의 시선을 추적하고, 각 탑승객이 바라보는 오브젝트를 탐지할 수 있다. 그리고, 각 탑승객이 제스처를 입력할 수 있는 서로 다른 인터페이스 공간을 설정할 수 있다. 상기 프로세서(190)는, 제1 및 제2 탑승객이 상기 차량에 탑승한 경우, 상기 제1 탑승객을 위한 제1 소정 공간에 제1그룹에 포함된 구역들을 설정하고, 상기 제2 탑승객을 위한 제2 소정 공간에 제2그룹에 포함된 구역들을 설정할 수 있다 . 상기 전자 제어 장치(100)는 상기 차량(1)의 운전석과 조수석 사이의 공간 또는 센터페시아에 배치될 수 있다. 이에 따라, 운전자와 조수석 탑승객은 운전석과 조수석 사이의 공간을 제스처를 입력하기 위한 공간으로 공유할 수 있다. 상기 프로세서(190)는 상기 제1 소정 공간과 상기 제2 소정 공간이 겹쳐지지 않도록 상기 제1 및 제2 소정 공간을 설정할 수 있다 . 이는, 제1 탑승객이 바라본 오브젝트와 관련된 기능이 제2 탑승객에 의하여 실행되는 오동작을 방지하기 위함이다. 상기 제1 소정 공간에 상기 제1 탑승객이 바라본 오브젝트와 관련된 기능들에 대응하는 복수의 구역들이 설정되고, 상기 제2 소정 공간에 상기 제2 탑승객이 바라본 오브젝트와 관련된 기능들에 대응하는 복수의 구역들이 설정될 수 있다. 예를 들어, 도 13에 도시된 바와 같이, 제1탑승객(1310)을 위한 제1 소정 공간(1312)이 운전석에 가깝게 설정되고, 제2 탑승객(1320)을 위한 제2 소정 공간(1322)이 조수석에 가깝게 설정될 수 있다. 상기 프로세서(190)는 상기 제1 소정 공간(1312)과 상기 제2 소정 공간(1322)을 가이드 하는 가이드 정보를 시각적, 청각적 및/또는 촉각적 방식 중 적어도 하나의 방식으로 출력할 수 있다. 일 예로, 상기 프로세서(190)는 도 6에서 상술한 방법으로 상기 제1 및 제2 소정 공간들(1312,1322)을 가이드 하는 영상을 상기 차량(1)의 디스플레이(400)에 출력할 수 있다. 다른 일 예로, 상기 프로세서(190)는 상기 제1 탑승객(1312)의 손이 상기 제2 소정 공간(1322)으로 진입하거나 진입할 것이 예상되는 경우, 상기 제1 탑승객의 손에 촉각 효과가 발생하도록 상기 햅틱 모듈(150)을 제어할 수 있다 . 상기 제1 소정 공간(1312)과 상기 제2 소정 공간(1322) 사이에는 햅틱 월(Haptic Wall, 1330)이 설정될 수 있다. 상기 햅틱 월은 벽이 있는 것과 같은 촉감을 발생시키는 공간으로, 상기 프로세서(190)는 상기 햅틱 모듈(150)을 통해 탑승객의 손 위치에 따라 선택적으로 상기 햅틱 월을 생성할 수 있다. 상기 햅틱 월에 의해 생성되는 촉각 효과는 탑승객의 손 위치에 따라 달라질 수 있다. 구체적으로, 상기 프로세서(190)는 상기 제1 탑승객(1312)의 손과 상기 제2 소정 공간(1322)의 중심점 사이의 거리에 따라 서로 다른 방식의 촉각 효과가 발생하도록 상기 햅틱 모듈(150)을 제어할 수 있다. 예를 들어, 상기 제1 탑승객(1312)의 손이 상기 제2 소정 공간(1322)의 중심점에 가까워질수록 더 큰 세기의 촉각 효과가 발생하고, 상기 제2 소정 공간(1322)의 중심점에서 멀어질수록 더 작은 세기의 촉각 효과가 발생할 수 있다. 상기 제1 탑승객(1312)의 손이 상기 햅틱 월(1330)에서 벗어나면, 상기 프로세서(190)는 촉각 효과가 발생하지 않도록 상기 햅틱 모듈(150)을 제어한다. 도 14는 복수의 탑승객들이 탑승한 경우의 제어방법을 설명하기 위한 흐름도이다. 상기 프로세서(190)는 탑승객을 기준으로 가상의 기준점을 설정할 수 있다(S1410). 상기 프로세서(190)는 상기 기준점 그리고 손의 움직임이 감지된 영역의 일 지점 사이의 거리에 근거하여 어느 하나의 기능에 이용되는 변수를 가변적으로 결정할 수 있다 (S1430). 예를 들어, 검지가 제1축을 따라 좌우로 이동하는 제스처에 의하여 스크롤 기능이 실행될 수 있다. 이때, 검지의 이동 속도 및/또는 이동 거리가 동일하더라도, 검지와 기준점 사이의 거리에 따라, 스크롤 되는 양이 달라질 수 있다. 상기 검지와 기준점 사이의 거리는 상기 제1축에 수직인 제2축을 기준으로 산출된다. 이경우, 변수는 스크롤 되는 양일 수 있다. 다른 예를 들어, 핀치 인/아웃의 제스처에 따라 컨텐츠의 확대 또는 축소 기능이 실행될 수 있다. 확대 또는 축소의 비율이 검지와 기준점 사이의 거리에 따라 달라질 수 있다. 이경우, 변수는 확대 또는 축소의 비율일 수 있다. 여기서, 상기 제2축은 상기 차량(1)의 전방과 후방을 연결하는 축으로, 도 4a에 도시된 y축이고, 상기 제1축은 x축일 수 있다. 상기 프로세서(190)는 상기 변수에 대응하는 촉각 효과가 발생하도록 상기 햅틱 모듈(150)을 제어할 수 있다 (S1450). 상기 프로세서(190)는 변수가 얼마나 큰지를 가이드 하기 위하여 변수에 대응하는 크기의 진동이 발생하도록, 상기 햅틱 모듈(150)을 제어한다. 전술한 본 발명은, 프로그램이 기록된 매체에 컴퓨터가 읽을 수 있는 코드(또는, 애플리케이션이나 소프트웨어)로서 구현하는 것이 가능하다. 상술한 자율 주행 차량의 제어 방법은 메모리 등에 저장된 코드에 의하여 실현될 수 있다. 컴퓨터가 읽을 수 있는 매체는, 컴퓨터 시스템에 의하여 읽혀질 수 있는 데이터가 저장되는 모든 종류의 기록장치를 포함한다. 컴퓨터가 읽을 수 있는 매체의 예로는, HDD(Hard Disk Drive), SSD(Solid State Disk), SDD(Silicon Disk Drive), ROM, RAM, CD-ROM, 자기 테이프, 플로피 디스크, 광 데이터 저장 장치 등이 있으며, 또한 캐리어 웨이브(예를 들어, 인터넷을 통한 전송)의 형태로 구현되는 것도 포함한다. 또한, 상기 컴퓨터는 프로세서 또는 제어부를 포함할 수도 있다. 따라서, 상기의 상세한 설명은 모든 면에서 제한적으로 해석되어서는 아니되고 예시적인 것으로 고려되어야 한다. 본 발명의 범위는 첨부된 청구항의 합리적 해석에 의해 결정되어야 하고, 본 발명의 등가적 범위 내에서의 모든 변경은 본 발명의 범위에 포함된다. The present invention relates to an electronic control device mounted on a vehicle. The electronic control device comprises: an image sensor for tracking a gaze of a passenger riding in the vehicle; a gesture sensor for tracking a gesture defined by at least one of a hand movement and a finger movement performed by the passenger; and a processor for searching for an object at which the passenger's gaze is directed and executing, in response to a case where the gesture satisfies a reference condition, one function corresponding to the gesture among functions associated with the object. 차량에 장착되는 전자 제어 장치로서, 상기 차량에 탑승한 탑승객의 시선을 추적하는 이미지 센서; 상기 탑승객의 손 및 손가락 중 적어도 하나의 움직임에 의하여 정의되는 제스처를 추적하는 제스처 센서; 및 상기 시선이 향하는 오브젝트를 탐색하고, 상기 제스처가 기준 조건을 만족하는 것에 응답하여 상기 오브젝트에 연관된 기능들 중 상기 제스처에 대응하는 어느 하나의 기능을 실행하는 프로세서를 포함하는 전자 제어 장치. 제1항에 있어서, 상기 프로세서는, 소정 공간에 상기 오브젝트에 연관된 기능들에 대응하는 복수의 구역들을 설정하고, 상기 제스처가 상기 복수의 구역들 중 어느 하나의 구역에서 수신되는 것에 응답하여 상기 어느 하나의 구역에 대응하는 상기 어느 하나의 기능을 실행하는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 상기 복수의 구역들은 3차원 행렬을 형성하는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 공기의 진동을 이용하여 촉각 효과를 발생시키는 햅틱 모듈을 더 포함하고, 상기 프로세서는, 상기 탑승객의 손이 상기 어느 하나의 구역의 가장자리에 위치하면 제1크기의 진동이 발생하고, 상기 어느 하나의 구역의 중앙에 위치하면 상기 제1크기보다 큰 제2크기의 진동이 발생하도록 상기 햅틱 모듈을 제어하는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 상기 프로세서는, 상기 탑승객이 제1 탑승객인 경우 각 구역의 크기를 제1크기로 설정하고, 상기 탑승객이 제2 탑승객인 경우, 각 구역의 크기를 상기 제1크기와 다른 제2크기로 설정하는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 상기 프로세서는, 상기 오브젝트에 근거하여 상기 소정 공간에 자연수인 n개의 구역들을 설정하며, 상기 n은 상기 시선이 향하는 상기 오브젝트에 따라 달라지는 것을 특징으로 하는 전자 제어 장치. 제6항에 있어서, 상기 프로세서는, 상기 n개의 구역들을 가이드 하는 영상이 상기 차량에 구비된 디스플레이에 표시되도록 상기 통신부를 제어하는 것을 특징으로 하는 전자 제어 장치. 제7항에 있어서, 상기 프로세서는, 상기 n개의 구역들 중 제1구역에 상기 탑승객의 손이 위치하는 경우, 상기 영상에서 상기 제1구역에 하이라이트가 이루어지도록 상기 통신부를 제어하는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 상기 프로세서는, 상기 오브젝트에 연관된 기능들 각각에 설정되어 있는 설정 값에 따라 각 구역의 크기를 조정하는 것을 특징으로 하는 전자 제어 장치. 제9항에 있어서, 상기 프로세서는, 상기 오브젝트에 연관된 기능들의 각각이 실행된 횟수에 근거하여 상기 설정 값을 업데이트하는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 상기 소정 공간은 상기 탑승객을 기준으로 정의되며, 상기 소정 공간의 크기 및 위치 중 적어도 하나는 상기 탑승객에 따라 달라지는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 상기 프로세서는, 기설정된 트리거 제스처가 감지되는 것에 응답하여 상기 소정 공간에 상기 복수의 구역들을 설정하며, 상기 트리거 제스처가 감지된 위치에 근거하여 상기 소정 공간의 중심점을 설정하는 것을 특징으로 하는 전자 제어 장치. 제2항에 있어서, 상기 프로세서는, 제1 및 제2 탑승객이 상기 차량에 탑승한 경우, 상기 제1 탑승객을 위한 제1 소정 공간에 제1그룹에 포함된 구역들을 설정하고, 상기 제2 탑승객을 위한 제2 소정 공간에 제2그룹에 포함된 구역들을 설정하는 것을 특징으로 하는 전자 제어 장치. 제13항에 있어서, 상기 프로세서는 상기 제1 소정 공간과 상기 제2 소정 공간이 겹쳐지지 않도록 상기 제1 및 제2 소정 공간을 설정하는 것을 특징으로 하는 전자 제어 장치. 제14항에 있어서, 공기의 진동을 이용하여 촉각 효과를 발생시키는 햅틱 모듈을 더 포함하고, 상기 프로세서는, 상기 제1 탑승객의 손이 상기 제2 소정 공간으로 진입하는 경우, 상기 제1 탑승객의 손에 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어하는 것을 특징으로 하는 전자 제어 장치. 제15항에 있어서, 상기 프로세서는, 상기 제1 탑승객의 손과 상기 제2 소정 공간의 중심점 사이의 거리에 따라 서로 다른 방식의 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어하는 것을 특징으로 하는 전자 제어 장치. 제1항에 있어서, 상기 프로세서는, 상기 탑승객을 기준으로 가상의 기준점을 설정하고, 상기 기준점 그리고 상기 손의 움직임이 감지된 영역의 일 지점 사이의 거리에 근거하여 상기 어느 하나의 기능에 이용되는 변수를 가변적으로 결정하는 것을 특징으로 하는 전자 제어 장치. 제17항에 있어서, 공기의 진동을 이용하여 촉각 효과를 발생시키는 햅틱 모듈을 더 포함하고, 상기 프로세서는, 상기 변수에 대응하는 촉각 효과가 발생하도록 상기 햅틱 모듈을 제어하는 것을 특징으로 하는 전자 제어 장치. 제1항에 있어서, 상기 프로세서는, 상기 시선이 상기 차량에 구비된 디스플레이를 향하는 경우, 상기 시선에 근거하여 상기 디스플레이에 포함된 복수의 그래픽 객체들 중 어느 하나를 상기 오브젝트로 탐색하는 것을 특징으로 하는 전자 제어 장치. 제1항에 있어서, 상기 프로세서는, 상기 오브젝트가 탐색되는 경우, 상기 오브젝트와 관련된 상세정보가 상기 차량에 구비된 디스플레이에 표시되도록 상기 통신부를 제어하는 것을 특징으로 하는 전자 제어 장치.